Apache Parquet 简介

Apache Parquet 是一种列式存储格式,专为高效处理大规模数据而设计。它最初由 Twitter 和 Cloudera 开发,现在是 Apache 软件基金会的顶级项目。Parquet 的设计目标是优化存储效率和查询性能,特别适合用于大数据分析和处理。

核心特性

Apache Parquet 是一种高效的列式存储格式,专为大规模数据处理而设计。其核心特性使其在大数据分析和存储方面具有显著优势。以下是 Parquet 的一些核心特性:

- 列式存储:Parquet 采用列式存储格式,将相同列的数据连续存储在一起。这种存储方式在进行聚合和筛选操作时非常高效,因为只需要读取相关的列数据,而无需扫描整个数据集。

- 高效压缩:由于同一列的数据通常具有相似的类型和取值范围,Parquet 的列式存储方式非常适合数据压缩。Parquet 支持多种压缩算法(如 Snappy、Gzip、LZO),可以显著减少存储空间占用。

- 灵活的编码方式:Parquet 支持多种编码方式,如运行长度编码(RLE)和字典编码等。这些编码方式可以进一步优化数据存储和读取性能。

- 嵌套数据结构支持:Parquet 支持复杂的嵌套数据结构,如数组、映射和结构体。这使得 Parquet 能够高效存储和处理 JSON 和 Avro 等半结构化数据。

- 丰富的元数据:Parquet 文件包含详细的元数据信息,如列的统计信息、编码类型和压缩算法。这些元数据可以帮助查询引擎在执行查询时进行优化,例如跳过不必要的数据块,提高查询效率。

- 跨平台兼容性:Parquet 可以在多种大数据处理框架中使用,包括Apache Hadoop、Apache Spark、Apache Hive、Apache Drill 和 Amazon Athena 等。这种跨平台支持使得 Parquet 成为一个通用的数据交换格式。

- 高效 I/O 操作:Parquet 的列式存储和压缩技术减少了 I/O 操作的次数和数据传输量,提高了数据读取和写入的效率。

- Schema Evolution:Parquet 支持模式演变,允许对数据模式进行向前和向后兼容的更改。这在处理不断变化的数据结构时非常有用。

Apache Parquet 的核心特性使其成为大数据处理和分析的理想选择。通过列式存储、高效压缩和编码、复杂数据结构支持以及跨平台兼容性,Parquet 能够显著提高存储效率和查询性能,满足大规模数据处理的需求。

使用场景

Apache Parquet 是一种高效的列式存储格式,特别适合大规模数据处理和分析任务。由于其性能优势和灵活性,Parquet 在多个领域和使用场景中得到了广泛应用。以下是一些典型的使用场景:

- 大数据分析:Parquet 非常适合用于需要处理大规模数据集的大数据分析任务。其列式存储格式能够提高查询性能,特别是在执行聚合和筛选操作时。大数据框架如 Apache Spark 和 Apache Hive 都支持使用 Parquet 格式进行数据存储和分析。

- 数据仓库:在数据仓库中,Parquet 常被用作数据存储格式,因为它可以显著减少存储空间占用并提高查询速度。许多现代数据仓库解决方案,如 Amazon Redshift 和 Google BigQuery,支持 Parquet 格式,以提高数据处理效率。

- ETL(Extract, Transform, Load)过程:在 ETL 过程中,Parquet 可以用作中间存储格式。其高效的读取和写入性能使得数据在提取、转换和加载过程中能够快速处理,缩短数据管道的执行时间。

- 机器学习:在机器学习项目中,Parquet 可以用于存储和处理大规模的训练数据集。其高效的读取性能可以加速数据预处理和模型训练过程。

- 日志和事件数据存储:对于日志和事件数据,Parquet 的压缩和列式存储特性能够显著减少存储成本,同时提高分析这些数据的速度。这对于需要长期存储和分析大量日志数据的应用特别有用。

- 实时分析和流处理:Parquet 也可以用于实时分析和流处理场景。虽然它本质上是一个批处理格式,但在某些实时分析框架中,Parquet 可以用于存储经过流处理后的结果,以便进行后续分析。

- 多格式数据集成:Parquet 可以与多种数据格式和源集成,使其成为数据湖和数据集成项目中的理想选择。通过将不同来源的数据转换为 Parquet 格式,可以实现高效的数据存储和查询。

- 云存储和计算:许多云服务提供商(如 AWS、Google Cloud 和 Azure)都支持 Parquet 格式,并在其存储和计算服务中优化了对 Parquet 文件的处理。这使得在云环境中使用 Parquet 进行大规模数据处理变得更加便捷和高效。

Apache Parquet 以其高效的存储和查询性能,在多个大数据处理和分析场景中得到了广泛应用。无论是批处理还是实时处理,无论是在本地还是在云环境中,Parquet 都为数据密集型应用提供了一种高效、灵活的数据存储解决方案。

文件结构

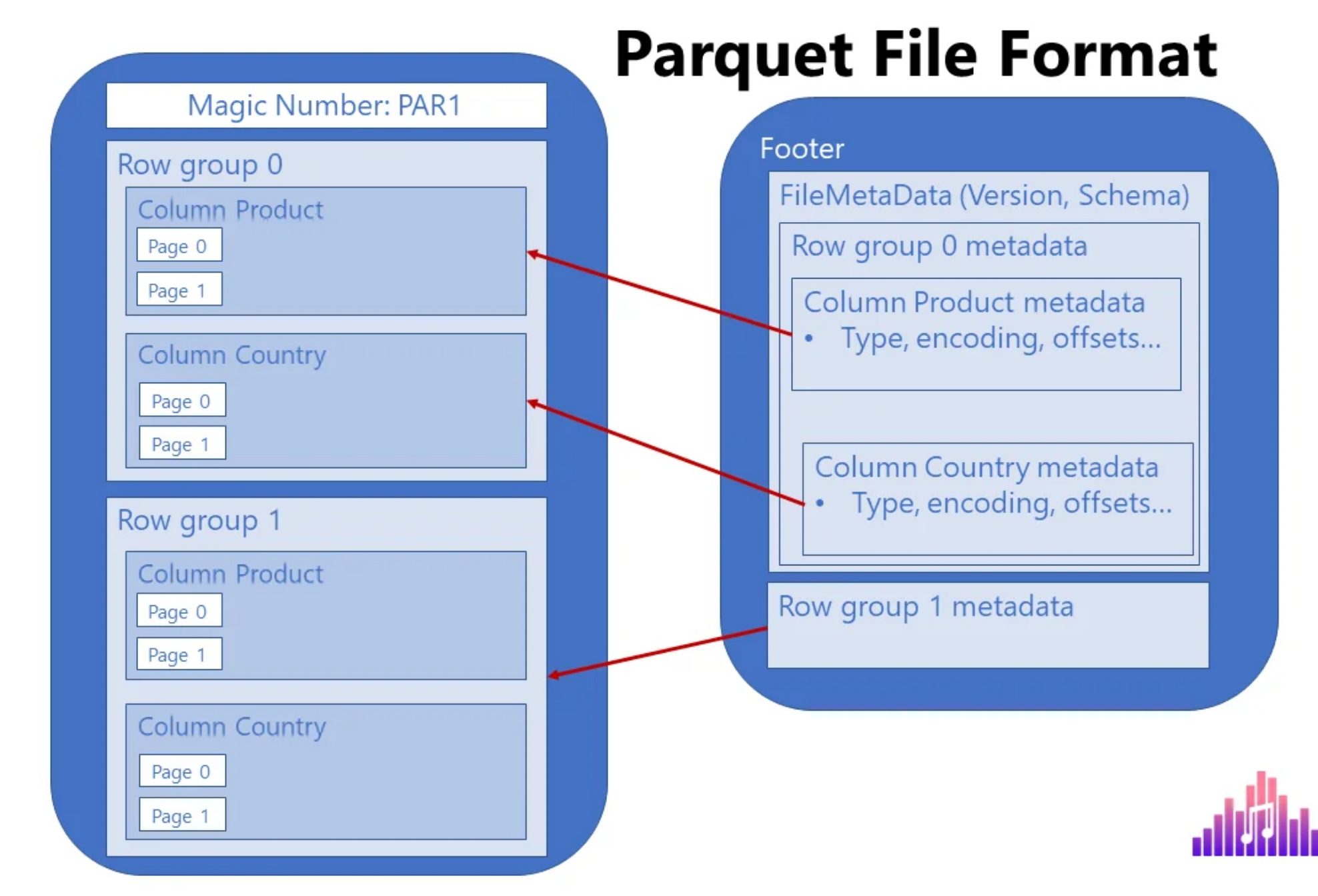

Apache Parquet 的文件结构经过精心设计,以支持高效的存储和查询操作。Parquet 是一种列式存储格式,其文件结构由多个层次组成,每个层次都有特定的功能和目的。

以下是 Parquet 文件的主要结构组件:

- 文件头(File Header):Parquet 文件以一个文件头开始。文件头包含魔术字节(magic number),用于标识文件格式,并确保文件是一个有效的 Parquet 文件。

- 行组(Row Groups):Parquet 文件被划分为多个行组,每个行组包含一定数量的行。行组是 Parquet 文件的基本单位,可以在读取时独立处理,从而提高并行处理能力。每个行组通常包含多个列块。

- 列块(Column Chunks):每个行组包含多个列块,每个列块存储一列的数据。列块是根据列存储的,这种列式存储方式有助于提高查询性能,因为在查询时可以只读取相关的列数据。

- 页面(Pages):

- 列块进一步划分为多个页面,每个页面包含一部分数据。页面是列块的基本存储单位,Parquet 支持多种类型的页面,包括数据页面、字典页面和索引页面。

- 数据页面:存储实际的数据值。

- 字典页面:用于字典编码,存储字典值。

- 索引页面:存储用于快速定位数据的索引信息。

- 文件尾(File Footer):

- 文件尾包含文件的元数据,包括所有行组、列块和页面的信息。元数据帮助查询引擎在执行查询时进行优化,例如跳过不必要的数据块。

- 文件尾还包含文件级别的元数据信息,如模式信息(schema)、编码类型、压缩算法等。

- 文件末尾标识(Magic Number):Parquet 文件的末尾还包含一个魔术字节,与文件头的魔术字节相同,用于确认文件的完整性。

文件结构的优势

- 高效查询:列式存储和丰富的元数据使得 Parquet 文件能够支持高效的查询操作。查询引擎可以利用元数据快速定位和读取相关的列数据,而不必扫描整个文件。

- 灵活性和可扩展性:行组和列块的划分使得 Parquet 文件能够支持大规模并行处理和高效的 I/O 操作。

压缩和编码优化:通过支持多种压缩和编码方式,Parquet 文件能够显著减少存储空间占用,同时提高读取性能。

Apache Parquet 的文件结构设计旨在优化大规模数据的存储和查询效率。通过采用列式存储、行组划分和多层次的元数据管理,Parquet 文件能够在多种大数据处理场景中提供卓越的性能和灵活性。

Apache ORC 简介

Apache ORC(Optimized Row Columnar)是一种高效的列式存储格式,专为 Hadoop 生态系统中的大数据处理而设计。ORC 文件格式通过优化数据存储和读取性能,减少存储空间占用,并提高查询速度,成为大数据分析的理想选择。

核心特性

Apache ORC(Optimized Row Columnar)是一种专为大数据处理优化的列式存储格式,主要用于 Hadoop 生态系统中的数据存储和分析。以下是 Apache ORC 的一些核心特征:

- 列式存储

- 数据组织:ORC 以列为单位存储数据,这种方式使得在进行分析时可以只读取所需的列,从而减少了 I/O 开销。

- 高效压缩:由于同一列的数据类型相同,ORC 能够更有效地压缩数据,提高存储效率。

- 索引和统计信息

- 内置索引:每个 ORC 文件包含内置索引信息,如最小值、最大值和中位数。这些索引帮助快速定位和过滤数据,提高查询性能。

- 布隆过滤器:支持布隆过滤器以加速基于键的查找操作,减少扫描的数据量。

- 优化的压缩算法

- 压缩支持:ORC 支持多种压缩算法,包括 ZLIB、Snappy 和 LZO。这些算法通过减少数据大小来降低存储和传输成本。

- 轻量级压缩元数据:ORC 文件在每个行组的末尾存储轻量级的压缩元数据,以便快速访问和解压缩。

- 高效的存储格式

- 行组(Stripe):ORC 文件被分成多个行组,每个行组包含行索引、数据和行尾。这种结构允许高效的并行处理和数据读取。

- 文件尾部元数据:文件尾部包含有关文件结构和内容的详细元数据,使得在读取文件时可以快速获取相关信息。

- 向前和向后兼容性

- Schema 演变:ORC 支持向前和向后兼容的数据格式,允许数据结构在不破坏现有应用的情况下进行演变和扩展。

- 性能优化

- 快速的查询性能:由于其高效的列式存储和丰富的索引机制,ORC 在处理大规模数据集时提供了快速的查询性能。

- 内存高效:ORC 的设计使得在内存使用上非常高效,尤其在大规模数据处理场景中表现优异。

- 深度集成

- 与 Hadoop 生态系统的集成:ORC 与 Apache Hive 紧密集成,专为 Hive 优化,同时也支持其他 Hadoop 生态系统组件,如 Apache Pig 和 Apache Spark。

- 安全性

- 加密支持:ORC 支持数据加密,确保数据在存储和传输过程中的安全性。

Apache ORC 是一种为大数据分析优化的列式存储格式,具有高效的压缩、丰富的索引和优异的查询性能等特点。它特别适合在 Hadoop 生态系统中使用,尤其是与 Hive 集成时,提供了显著的性能提升和存储效率。通过利用 ORC 的这些核心特征,用户可以在大数据处理任务中获得更高的性能和更低的成本。

使用场景

Apache ORC(Optimized Row Columnar)是一种高效的列式存储格式,专为大数据处理优化,特别适合在 Hadoop 生态系统中使用。以下是 ORC 的一些典型使用场景:

- 大数据分析

- 数据仓库:ORC 在数据仓库环境中非常有用,特别是在使用 Apache Hive 进行大规模数据分析时。其列式存储和压缩特性可以显著提高查询性能和减少存储成本。

- ETL 处理:在 Extract, Transform, Load (ETL) 过程中,ORC 格式可以用于存储中间结果和最终数据集,提供快速的读取和写入性能。

- 高效存储和压缩

- 存储优化:ORC 的高效压缩算法使其非常适合用于存储需要压缩以节省空间的大规模数据集,特别是在云存储和数据湖场景中。

- 冷数据存储:对于不经常访问但需要高效存储的数据,ORC 提供了一个高效的解决方案。

- 快速查询和检索

- BI 工具集成:ORC 可以与多种商业智能(BI)工具集成,提供快速的数据访问和分析能力,适合用于需要实时或近实时查询的应用。

- 数据挖掘和机器学习:在数据挖掘和机器学习工作流中,ORC 格式的数据可以快速加载到分析工具中,支持大规模数据的高效处理。

- Hadoop 生态系统集成

- Apache Hive:ORC 与 Hive 的深度集成,使得它成为 Hive 中最常用的存储格式之一。它优化了 Hive 查询的性能和效率。

- Apache Spark:尽管 ORC 最初为 Hive 优化,它也支持在 Apache Spark 中使用,适合需要与 Hive 数据兼容的 Spark 应用。

- 实时数据处理

- 流处理:在流处理场景中,ORC 可以用于存储流数据的历史记录,提供快速的查询能力以支持实时分析和决策。

- 实时数据仓库:ORC 支持的快速数据加载和查询能力,使其适合用于构建实时数据仓库,支持快速的数据访问和更新。

- 数据湖

- 数据湖存储:在数据湖环境中,ORC 可以用于存储结构化和半结构化数据,提供高效的存储和管理方案,支持多种分析和处理工具。

- 数据安全

- 加密数据存储:ORC 支持数据加密功能,可以用于存储需要高安全性的数据,确保数据在传输和存储过程中的安全。

Apache ORC 在需要高效存储、压缩和快速查询的大数据场景中表现尤为出色。它的设计和优化使其成为 Hadoop 生态系统中广泛应用的存储格式之一,特别是在使用 Apache Hive 和其他大数据处理工具时。通过利用 ORC 的优势,用户可以在大数据分析、存储优化和实时处理等方面获得显著的性能提升。

文件结构

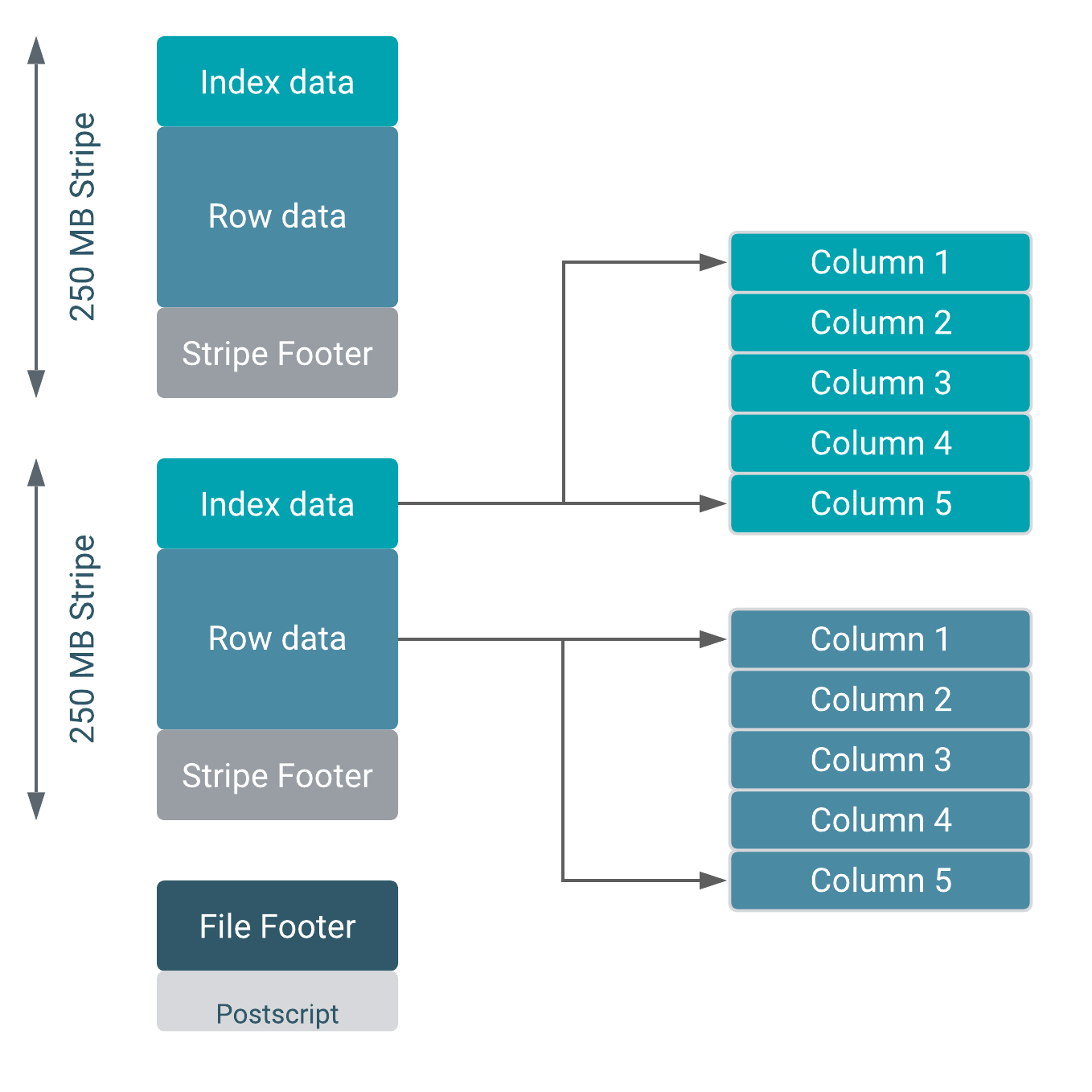

Apache ORC(Optimized Row Columnar)文件结构设计旨在提高大数据存储和处理的效率。其文件结构由多个关键部分组成,以支持高效的数据压缩、存储和查询。以下是 ORC 文件的主要结构组件:

- 文件头(File Header)

- 文件标识:ORC 文件以一个文件标识开始,用于标识文件类型。这是为了确保读取工具能够正确识别文件格式。

- 行组(Stripe):ORC 文件被分为多个行组(Stripe),每个行组包含多个行的数据。这种分块设计有助于并行处理和高效的数据读取。每个行组包括以下几个部分:

- 索引数据(Index Data):包含每列的索引信息,如最小值、最大值和其他统计信息。这些索引数据帮助快速定位需要的行组,提高查询效率。

- 数据(Data):实际的数据存储部分,按列存储。列式存储使得只需读取相关的列数据,减少了不必要的 I/O 开销。

- 行组尾部(Stripe Footer):包含该行组的元数据,如列的类型信息和解码信息。行组尾部帮助快速获取行组的结构信息。

- 文件尾部(File Footer)

- 文件级元数据:文件尾部包含整个文件的元数据,包括每个行组的位置、列的统计信息和文件的整体结构信息。

- 类型描述:描述文件中每个列的数据类型。

- 文件后缀(Postscript)

- 压缩信息:包含文件的压缩类型和压缩块大小。

- 版本信息:文件格式版本信息,用于兼容性检查。

- 元数据大小:文件尾部的元数据大小,用于快速定位和读取文件尾部。

- 压缩:ORC 文件结构支持多种压缩算法(如 ZLIB、Snappy 和 LZO),以减少存储空间和提高读取效率。压缩是在列级别进行的,这允许更高效的压缩比,因为同一列中的数据通常具有相似的特征。

- 文件级元数据:文件尾部包含整个文件的元数据,包括每个行组的位置、列的统计信息和文件的整体结构信息。

Apache ORC 文件结构通过分割为多个行组、使用列式存储和提供丰富的索引与元数据,大大提高了大数据的存储和处理效率。它的设计使得在进行大规模数据分析时,可以显著减少 I/O 开销,提供快速的查询性能和高效的存储解决方案。

ORC 与 Parquet 的区别

Apache ORC(Optimized Row Columnar)和 Apache Parquet 是两种用于大数据生态系统中的列式存储格式。它们都旨在提高大数据处理的性能,尤其是在读取和压缩方面,但在设计和实现上存在一些关键区别。

数据模型和架构

- 数据模型:

- ORC:专为 Hive 优化,最初是为了解决 Hive 原始文件格式的性能问题。它的设计更侧重于 Hive 的数据模型。

- Parquet:基于 Google 的 Dremel 技术论文,采用了基于行组和列块的存储方式,适用于更广泛的分析工具和处理框架。

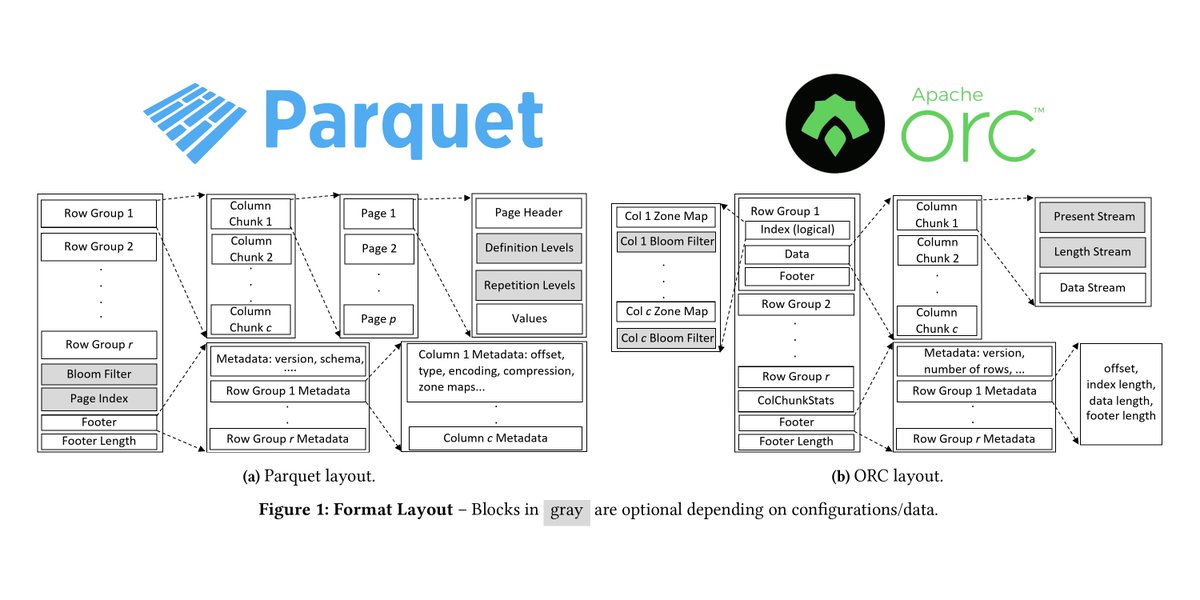

- 文件结构:

- ORC:文件分为文件头、行组(stripe)、文件尾。每个行组包含索引、数据和尾部信息。

- Parquet:文件由行组组成,每个行组包含多个列块。每个列块包含页面(数据页、字典页、索引页)。

性能和压缩

- 压缩:

- ORC:支持 ZLIB、Snappy、LZO 等压缩算法,提供了轻量级的压缩元数据存储,压缩效果通常优于 Parquet。

- Parquet:支持 GZIP、Snappy 等压缩算法。压缩率可能稍逊于 ORC,但在某些场景下,Parquet 的压缩效果会更好。

- 查询性能:

- ORC:由于其专为 Hive 优化,在 Hive 中的查询性能通常优于 Parquet。

- Parquet:在使用 Spark、Impala、Drill 等工具时,Parquet 的性能通常表现更优。

生态系统和兼容性

- 生态系统:

- ORC:主要与 Apache Hive 紧密集成,适用于 Hadoop 和 Hive 生态。

- Parquet:广泛支持于 Apache Hadoop、Apache Spark、Apache Drill、Apache Impala、Apache Flink 等大数据工具和框架。

- 兼容性:

- ORC:与 Hive 的集成度较高,适合与 Hive 结合使用的场景。

- Parquet:由于其广泛的支持,适合在多种工具和平台中使用,尤其是 Spark 和 Impala。

数据类型支持

- ORC 和Parquet 都支持丰富的数据类型,包括基本数据类型(如整数、浮点数、字符串)和复杂数据类型(如结构体、数组、映射)。不过,具体的数据类型实现和支持可能会有所不同,取决于它们的集成工具。

其他特性

- 索引和统计信息:

- ORC:内建了更丰富的索引和统计信息,如最小值、最大值、布隆过滤器等,帮助加速查询。

- Parquet:提供基本的统计信息,但索引能力可能不如 ORC 丰富。

- 文件尾部元数据:

- ORC:包含文件的完整元数据,帮助快速获取文件信息。

- Parquet:也包含文件的元数据信息,支持快速的文件扫描和过滤。

总结

选择 ORC 或 Parquet 主要取决于使用的工具和应用场景:

两者都是优秀的列式存储格式,各自具有独特的优势和适用场景。在实际应用中,可以根据具体的需求和使用环境进行选择。

参考链接: