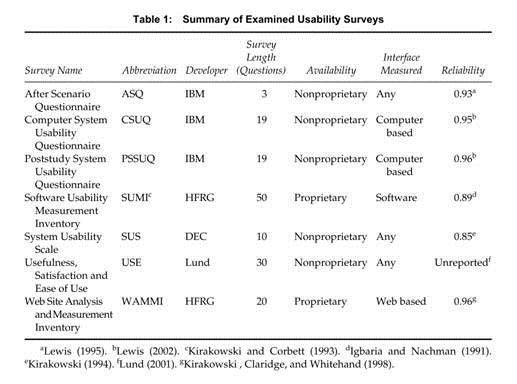

最近收到了对两个平台进行对比调研的需求,原以为做下简单的问卷设计就可以了,找了一些资料发现中间的门道还是非常的深,想要很好的掌握实属不易。可用性测试的问卷有很多中,如下图:

什么是标准化的问卷

问卷是一种用于获取被测者信息的表格,问卷的题目可以是开放式的问题,但更典型的是选择题或打分题。标准化问卷是被设计为可重复使用的问卷,通常有一组特定的问题使用特定的格式按照特定的顺序呈现,基于用户答案产生的度量值具有一定的规则(对于用户的回答,也有特定的计算方法和规则。)。作为标准化问卷设计的一部分,设计者通常需要报告问卷测量的信度、效度和灵敏度,换言之,问卷需要经过心理测量的条件审查(并不是每一份被重复使用的问卷就能称为标准化问卷)。

标准化问卷的评估:信度、效度和灵敏度

对标准化问卷的质量的测试指标主要是信度和效度。

- 信度:测量一致性。它衡量的指标是:对同一对象测量得到的结果是否一致。一般信度的评估包括重复测量信度和分半信度,最常见的方法α系数法。信度范围在0到1之间,对于问卷的信度,并没有固定的要求,不同内容的问卷对信度的要求不一样,但是,那些有着重要影响的问卷,例如IQ测试等,我们对其信度要求高,一般达到9以上,而一些其他的问卷,信度要求7以上就能够接受。

- $\alpha$信度系数是目前最常用的信度系数,其公式为:$\alpha=\frac{k}{k-1}\times(1-\frac{\sum S_i^2}{S_T^2})$,其中,K为量表中题项的总数,$S_i^2$为第i题得分的题内方差,#S_T^2#为全部题项总得分的方差。从公式中可以看出,$\alpha$系数评价的是量表中各题项得分间的一致性,属于内在一致性系数。这种方法适用于态度、意见式问卷(量表)的信度分析。总量表的信度系数最好在8以上,7-0.8之间可以接受;分量表的信度系数最好在0.7以上,0.6-0.7还可以接受。α系数如果在0.6以下就要考虑重新编问卷。

- 效度:测量有效性。确定有效性有不同的方式。确定有效性有几种不同的方法:

- 内容效度是一种通过考察条目出处的理性而非经验的评估。通常,如果条目是由领域专家创建,或是引用于目标领域或相关领域已有调查问卷的文献中,则我们可以预设该内容是有效的。

- 效标关联效度是指测量结果与某种预设或并发测量这边的相关性,通常使用皮尔逊相关系数来评估。这些相关性并不需要很大就能证明有效性。

- 结构效度是指为问卷所选的条目与调查问卷锁设计的评估基础结构之间的一致性程度。问卷调查人员使用统计程序(主要是因子分析)来发现或确定相关项目的集群。当项目以合理(或按预期的)的方式聚集在一起时,这不仅体现了构建效度,也是形成合理分量表的基础。测量之间在结构上存在高度的相关性可以被认为时聚合效度的证据,反之,在结构上没有达到预期一致性可以被认为时分歧效度的证据。

- 灵敏度的间接指标时产品比较时达到统计显著性所需的最小样本量,问卷越灵敏,所需的样本量最小。

标准化可用性问卷的优点

- 客观性:允许可用性测试的从业者独立的验证其他从业者的报告。

- 复用性:可以轻松复用别人的研究,甚至是自身的研究。例如,可用性测试的研究一再表明,标准化可用性问卷比费标准化可用性问卷更可靠。

- 量化:标准化测量使得从业者的报告结果有更细微的细节,而不仅只有个人判断。标准化也运行从业者使用高效的数学和统计学方法来理解他们的结果。

- 经济:开发标准化测试需要大量的工作。但是,一旦开发出来,他就能重复使用,非常经济。

- 沟通:当标准化测试可用时,从业者能更加方便的进行有效沟通。

- 科学的普适性:科学结果的普适性是科学工作的核心。标准化对评估结果的普适性必不可少。

常见的标准化可用性问卷

我们在做产品或系统的可用性测试后,都想把结果更好地传递给相关方。除了定性的研究结果之外,还有定量的可用性问卷,这些可用性问卷是标准化的,不仅可以科学地量化用户体验,也方便相关方之间有效沟通。常见的标准化可用性问卷有整体评估问卷、任务评估问卷和网站感知可用性评估问卷:

- 整体评估问卷:用于完成一系列任务场景后,对产品或系统整体的感知可用性测量。

- QUIS(用户交互满意度问卷)

- SUMI(软件可用性测试问卷)

- PSSUQ(整体评估可用性问卷)

- SUS(系统可用性量表)

- UMUX(用户体验的可用性指标)

- UMUX-LITE(用户体验的可用性指标-简化版)

- 任务评估问卷:每完成一个场景任务,让用户对该任务进行感知可用性测量。

- ASQ(场景后问卷)

- SEQ(单项难易度问卷)

- SMEQ(主观脑力负荷问题)

- ER(期望评分)

- UME(可用性等级评估)

- 网站感知可用性评估问卷:大部分标准化可用性问卷最初在20世纪80年代中期到后期被开发,在网络开始流行时,出现了更有针对性的评估网站感知可用性的问卷。

- WAMMI(网站分析和测量问卷)

- SUPR-Q(标准化的用户体验百分等级问卷)

- SUPR_Qm(APP用户体验量表)

- 用户心理负荷的测量:用户在使用产品时的心理负荷水平也直接影响着用户的主观满意度。

- SWAT(主观性工作负荷评估技术 Subjective Workload Assessment Technology)

- NASA-TLX(NASA任务负荷指数 National Aeronautics and Space Administration-Task Load Index)

- 其他有趣的问卷

- CSUQ(电脑系统可用性问卷)

- USE(有用性、满意度、易用性)

- HQ(享受性质量)

- EMO(情绪指标结果)

- ACSI(美国顾客满意度指数)

- NPS(净推荐值)

- CxPi(福雷斯特客户体验指数)

- TAM(技术接受模型)

用户交互满意度问卷QUIS

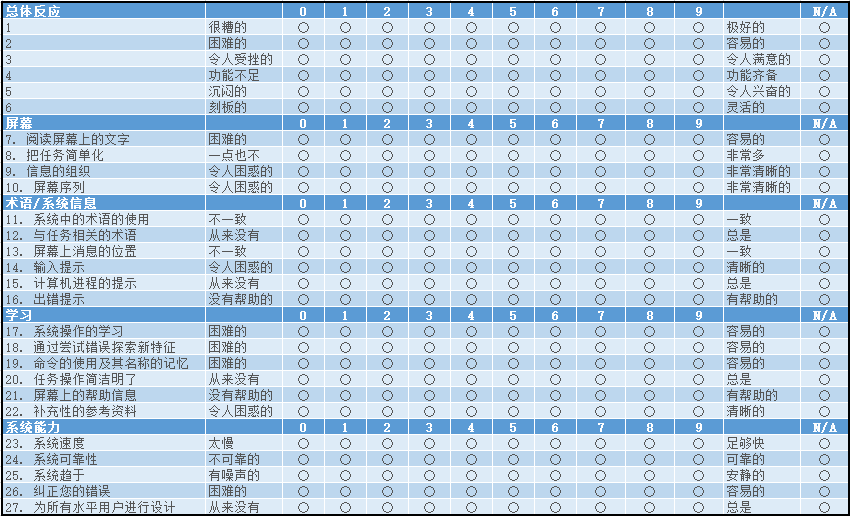

用户界面满意问卷(Questionnaire for User Interface Satisfaction, QUIS)是由马里兰大学的人机交互实验室(Human-Computer Interaction Laboratory, HCIL)中的一个研究小组编制的(Chin、Diehl和Norman, 1998年)。

使用QUIS必须取得马里兰大学办公室的许可。目前学生的许可费用是50美元,学术或非盈利许可费用为200美元,商业许可为750美元。

第一个长版本的QUIS有90个项目,以下为简短版本5。简短版本QUIS包括27个评价项目,分为5个类别:总体反应(Overall Reaction)、屏幕(Screen)、术语/系统信息(Terminology/System Information)、学习(Learning)和系统能力(System Capability)。评分是在一个10点标尺上进行,标示语随着陈述句的不同而发生变化。前6个项目(评估总体反应)没有陈述性的题干,只是一些截然相对的标示语词对(如很糟糕/很棒、困难/容易、挫败/舒适等)。

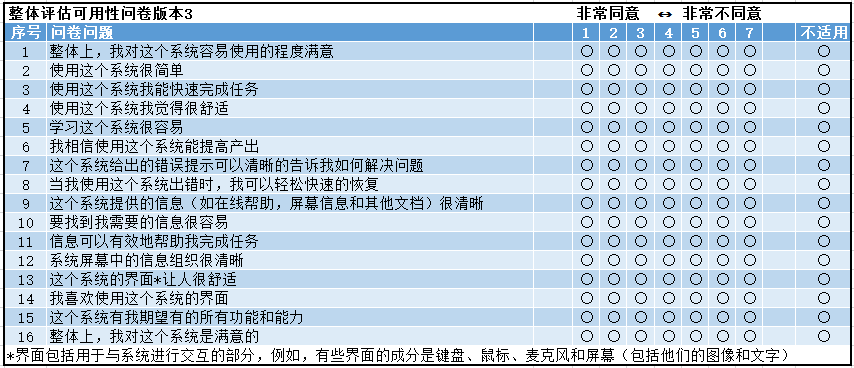

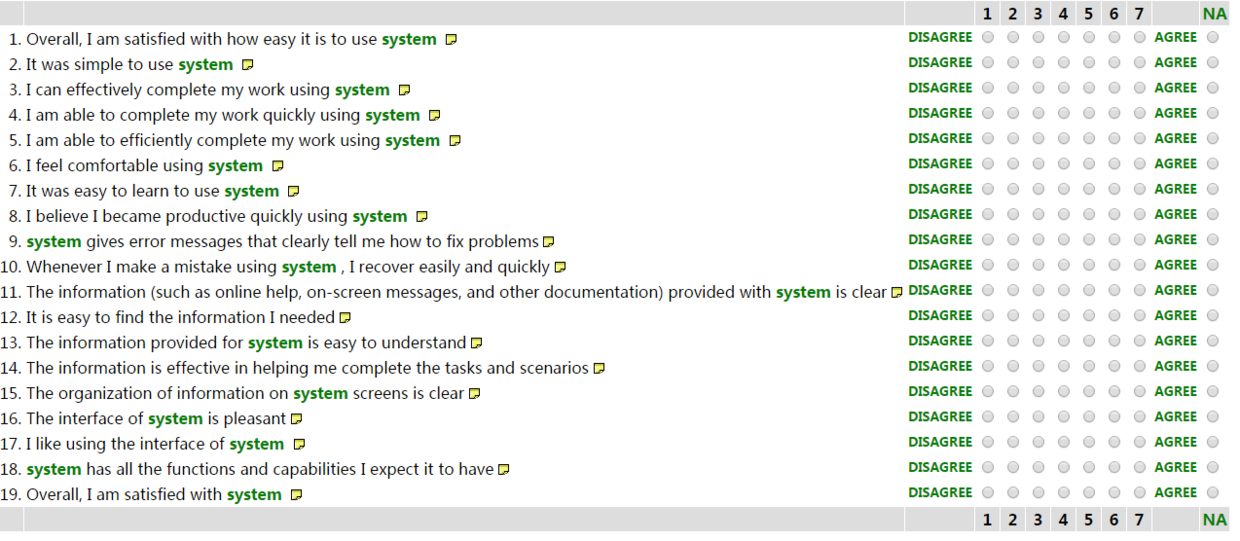

整体评估可用性问卷 PSSUQ

PSSUQ(整体评估可用性问卷,Post-Study System Usability Questionnaire)问卷用于评估用户对计算机系统或应用程序锁感知的满意度。PSSUQ 的起源是 IBM 的一个内部项目,称为 SUMS(系统可用性度量,System Usability Metric S),经过多个版本的迭代,目前用的比较多的是第三版。

在主持的可用性测试中,填写 PSSUQ 前给用户的说明如下:

您能通过本问卷告诉我们您使用系统的反馈。您的反馈可以帮助我们了解您对系统特别关心和满意的方面。为了尽可能好地完成这些题项,请您在回答的时候回想您在系统中执行的所有任务。青阅读每一个描述,表明您同意或不同意这些描述的程度。如果一个描述对您不适用,请圈“不适用”。请通过评论对您的答案进行精细描述。当您完成这个问卷后,我会跟你一起回购答案,以确定我了解您的所有反馈。谢谢!(Lewis,1995,p77)

PSSUQ 问卷有四个分数,一个整体和三个分量表。计算规则如下:

- 整体:题项 1~16 的反应平均值

- 系统质量:题项 1~6 的平均值

- 信息质量:题项 7~12 的平均值

- 界面质量:题项 13~15 的平均值

结果分数介于 1~7 分之间,分数低表示更高的满意度。如果从业人员需要,可以增加问题的题项目或在有限的程度中,可以对特定背景意义不大的题项进行删除。

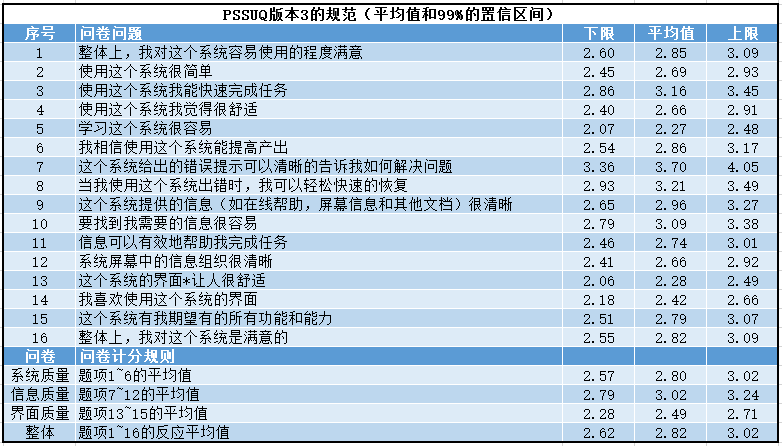

PSSUQ 的心理评估

版本 3 的信度为:

- 整体:94

- 系统质量:9

- 信息质量:91

- 界面质量:83

所有的信度都超过 0.8,这表明问卷具有足够的信度作为标准化的可用性测量。

PSSUQ 的基准

各版本的 PSSUQ 题项和问卷基准高度相关。以下为版本 3 的最佳可用基准:

注:这些历史研究是基于 PC 系统得到的数据,用于手机端的度量需要再解释的时候特别注意,并在长期积累了手机端数据之后,对解释作适合于自己的修订。

题项评分最差的是第 7 项,对评分一直较差的第 7 项的建议:

- 如果这种情况发生在你的数据里,不要觉得奇怪。

- 一个产品很难提供有用的错误提示信息。

- 专注于提供有用的错误提示信息可能是值得我们付出努力的。

- 如果你发现,这个题项的平均值等于或低于信息质量的其他题项平均值,你有可能到了高于平均水平的错误消息。

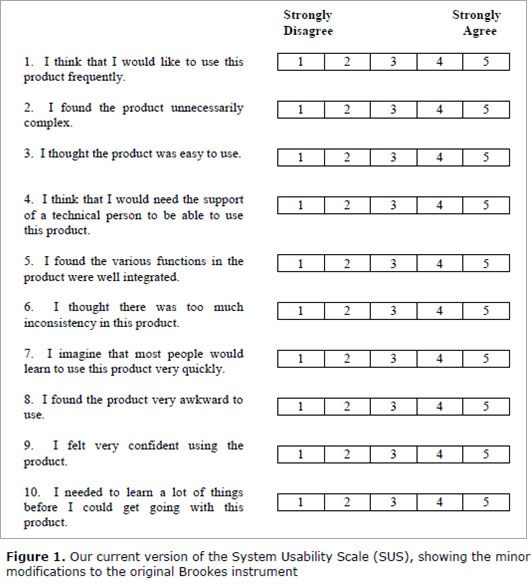

系统可用性量表 SUS

SUS (System Usability Scale) 于 20 世纪 80 年代中期编制而成,尽管编制者将其描述为“快速而粗糙”的可用性问卷,但是丝毫不影响它的受欢迎程度。SUS 量表被认为是 80 年代经典的可用性问卷标准,用于评估对整体系统的可用性,全球大约 43% 的专业机构进行整体评估时,将 SUS 量表作为测试后问卷题目。SUS 总共有 10 个问题,置信度为 85%。

SUS 调研内容

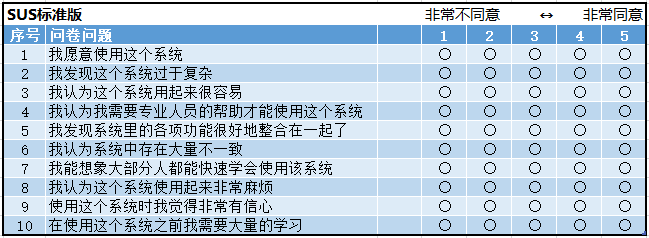

SUS 总共包含 10 题,5 分制。奇数项是正面描述题,偶数项是反面描述题。

翻译成中文:

注意:在使用 SUS 的过程中,可以对题目的词语进行替换,这些替换对最后的测量结果都没有影响。比如“system”可替换成网站、产品或者自己产品的名称等。

SUS 的优点

SUS 量表是通过大量实验为基础的量表设计,也是现在全球使用最多的整体性可行性评价量表。

- 正反语气间隔,使答案客观。SUS 问卷中大家可以发现奇数问题是正面语气,偶数问题是负面语气,这样减少了被测试者的依从性,从而使结果更加客观。

- 问题可量化为百分数。正面问题转化分值为 x-1,负面问题为 5-x,所有题目得分后乘以 5 即得到分值。

- 步距为奇数。从非常不同意到非常同意,我们一般使用奇数,有很多量表也是这样规定的。因为用户可以选择一个中间状态而不像偶数那样,不具有这个中间状态。

- 快速收敛到正确结论。在对几种量表研究的同时,SUS 是最快达到想要结论的量表。通常来讲,一个量表所测量出的结果与用户真实的意向具有一定的偏差,经研究 SUS 量表能够在不超过 15 个样本得到该系统的真实评价,所以该量表具有相当的灵敏性。

- SUS 量表包含易学性与可用性。其中 4 和 9 是易学性,其余的表示可用性。这个两个方面代表了整体评价的 2 个主体方面。具体的题设数量设计,是通过大量的样本研究发现后得出的。

SUS 的使用场景

- 同一个界面,完成不同的任务之间进行比较(因为有的任务可能会更难或不常使用,例如安装软件这个操作可能只需执行一次,而不像其他操作那样频繁使用;用户在完成不同类型和难度的任务之后,分别评多次 SUS 的分数,然后再进行对比,因为如果所有任务只评一个 SUS 分数的话,可能会因为某些任务较难而降低了评分);

- 同一个界面,先后不同版本之间进行比较(不过需要注意的是增加新功能或改版后,用户在初期可能会不适应,而导致 SUS 在短期内会下降,但长期会回升)

- 备用方案之间、竞品之间进行比较。

- 不同种类的界面之间进行比较(例如同一个产品有 PC 版、WAP 版、Android 版、iOS 版、微信小程序)

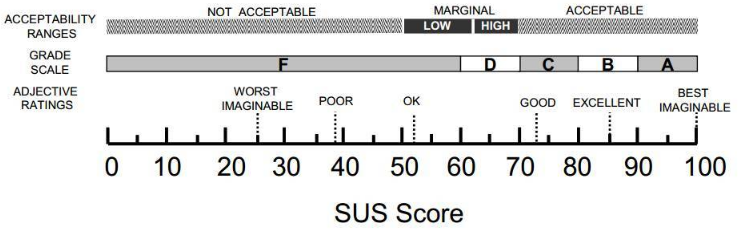

SUS 分值解读

SUS 分数反映的是总体的可用性,单独抽取某个题目的得分在产品之间作横向比较意义不大

针对 SUS 心理测试特征进行的最大研究中,Bangor 等(2008)对收集到的 2324 份 SUS 问卷进行了因子分析,进而得出结论:SUS 量表只有一个显著因子。Lewis 和 Sauro(2009)重新分析了 Bangor 等人的数据以及另一个来自于 Lewis 和 Sauro(2009)的独立的 SUS 个案后发现,两个研究中数据的因子都聚合到两个因子中。Borsci 等(2009)在同一年晚些时候使用了不同的测量模型和一批独立的数据,也得到同样的结论:SUS 量表由 2 额因子构成:题项 1、2、3、5、6、7、8、9 构成因子一,题项 4、10 构成因子二。

Lewis 和 Sauro(2009)根据题目的内容将题项 1、2、3、5、6、7、8、9 构成的分量表命名为“可用性”,由题项 4、10 构成的分量表命名为“易学性”。Lewis 和 Sauro(2009)对数据进行分析,“可用性”子量表的可信度为 0.91,“易学性”分量表的可行度为 0.7。为使可用性和易学性分数能够与整体 SUS 量表分数兼容,范围也是 0~100,需要对原始数据进行分化转化:可用性量表总分数乘以 3.125,易学性量表总分数乘以 12.5。

Borsci 等(2015)发现 SUS 针对那些没有什么在线学习工具使用经验的人的分析结果呈线性结构,但对那些经验丰富的用户分析结果呈现二维性结构(可用性及易学性维度)。由于 2009 年以来发现了相互矛盾的实验情况,因此我们建议从业者在考虑使用可用性及可学性这两个维度的时候要格外小心,特别是当被测用户在使用产品过程中没有特别强烈的体验的时候。

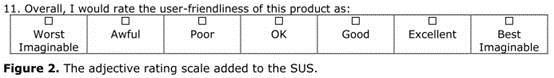

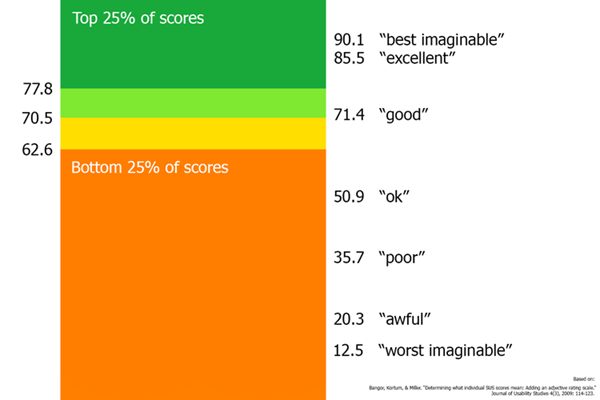

如果某个界面的 SUS 分数为 76,这表示什么?AT&T Labs的Bangor, Kortum和Miller在2009年发了一篇文章来解决这个问题。他们在SUS的结尾增加了1个问题(见下图),让用户使用Poor、Ok、Good等形容词来总体评价这个用户界面,其用意是想将SUS与这些形容词关连起来。

以下是每个形容词对应的SUS分数:按照这次的数据,被用户评为Good的那些界面,SUS的平均分为71.4。

不过Bangor等人并没有明确说,是否有足够的证据来证明可以使用71.4或某个分数来判断一个产品是否合格。

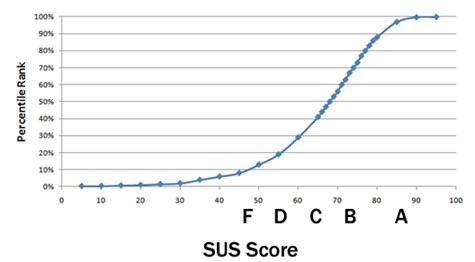

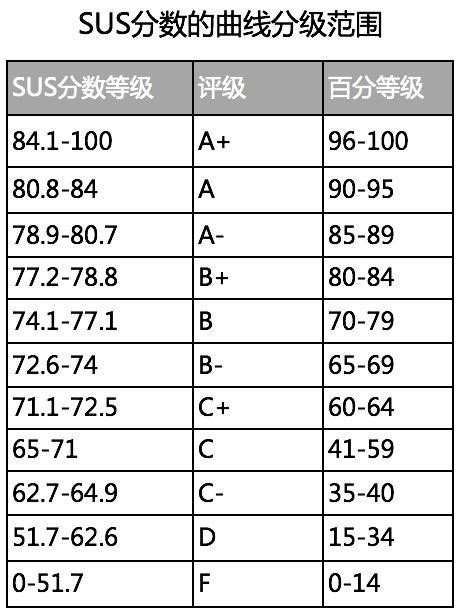

除此之外,也可以将SUS分数换算成百分等级来解释,百分等级的意思是指测量的产品或系统相对于总数据库里其他产品或系统的可用性程度。比如SUS得分是73分,其百分等级大约为67,意味着比大约66%的产品可用性更好。

注意,这里的总数据库是Jeff Sauro(2011)通过446个研究,超过5000个用户的SUS反馈的数据库。如果从企业研究团队的角度来看,可以沉淀以往的研究,建立企业自己产品或系统的SUS数据库,从而获得自身的基准数据,当然,这个基准数据也有可能是内部团队制定。在这个分数库中,如果SUS得分为74,那么它比500多个界面中的70%都要高(见下图):

本质上,百分等级用于说明你的应用程序相对于总数据库里其他产品的可用性程度。在表格中找到最接近你SUS值的分数,然后查看对应评级和百分等级。

参考链接:

- SUS: A Quick and Dirty Usability Scale by John Brooke

- Measuring Usability with the System Usability Scale (SUS) by Jeff Sauro

- SUS: A Retrospective by John Brooke

- Determining What Individual SUS Scores Mean: Adding an Adjective Rating Scale by Kortum Bangor and Miller May

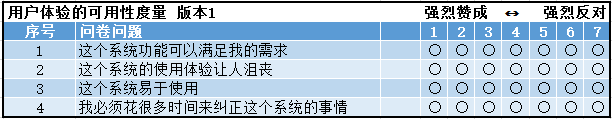

用户体验可用性指标UMUX

UMUX

UMUX是一套相对较新的标准化可用性问卷调查表。UMUX的主要目标是使用较少的题项来满足ISO定义的可用性(有用、高效、令人满意)调研。题项少并不代表不好,在某些情况下,较短的问卷可能更有用。

UMUX的强大之处在于其感知可用性度量与SUS的测量结果基本一致(与SUS标准版相关系数0.9)。

UMUX的可靠性$\alpha$系数为0.94。

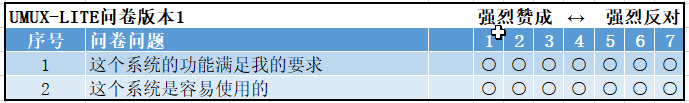

UMUX-LITE

如果觉得上面的题项还是太多,可以使用更为精简版的UMUX-LITE,UMUX-LITE主要测量的内容为“有用性”(项目1)和“易用性”(项目1)。具体问卷内容为:

UMUX-LITE的可靠性$\alpha$系数为0.82,与SUS标准版的相关系数为0.73

总结,虽然UMUX比较相比较简短,但是SUS更多的已经被验证。所以如果期望数据更准确,推荐使用SUS。

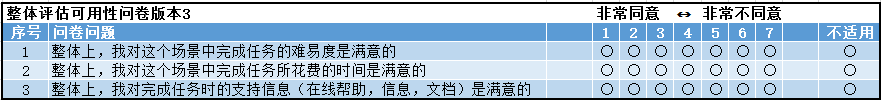

场景后问卷ASQ

场景后问卷(After-Scenario Questionnaire,ASQ)由PSSUQ和CSUQ的作者Lewis(1993)发表。总共包括三个项目,分别测量用户在三个方面的满意度:任务难度、完成效率和帮助信息。场景化问卷的开发与PSSUQ采用相同的形式,探测整体上完成任务的难易度、完成时间和支持信息的满意度。ASQ的项目采用从1(强烈同意)到7(强烈不同意)的7点计分。ASQ分数即是3个项目得分的平均分。Lewis (1995)的研究指出ASQ分数与PSSUQ分数的之间存在r=0.8的强相关,与场景任务的成功率也存在r=-0.4的显著相关。

ASQ问卷内容:

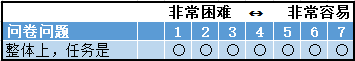

单项难易度问卷SEQ

单项难易度问卷(Single Ease Question,SEQ)只是要求评估完成任务的整体难易度,类似与ASQ第一项。SEQ的评分方式包括5点计分和7点计分,但根据目前的研究结果,7点评分拥有更高的信效度。

Sauro and Dumas (2009)发现SEQ分数与SUS得分呈现r=-0.56的的中等相关,与任务完成时间(r=-0.9)和任务出错率(r=-0.84)均存在显著相关性。同时,通过比较了SEQ、SMEQ和UME三个任务后评估问卷,他们也发现SEQ分数与SMEQ分数存在r=0.94的强相关,与UME分数存在r=0.95的强相关。

SEQ问卷内容:

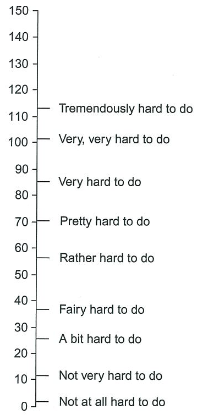

主观脑力负荷问题SMEQ

主观脑力负荷问题(Subjective Mental Effort Question,SMEQ)由 Zijlstra & van Doorn(1985)年发表,仅包含有一个项目,是一个从 0 到 150,包括 9 个文字标签的定距测量 (Jeff Sauro & Dumas, 2009)。在 SMEQ 的纸质版本中,被测这画一条线穿过问卷(问卷长度为 150mm)来表示完成任务所感知的脑力负荷,在 Sauro 和 Dumas(2009)开发的在线版本中,被测者使用一个滑块空间来调整他们的打分。与 ASQ 或 SEQ 不同,SMEQ 的测量得分为定距分数。这意味着得分 45 与 50 之间的差距与得分 120 与 125 之间的差距是一样的,更加便于比较。

Sauro and Dumas (2009) 发现 SMEQ 分数与 SUS 得分呈现 r=-0.60 的的中等相关,与任务完成时间(r=-0.82),任务完成率(r=0.88)和出错率(r=-0.72)均存在显著相关性。同时,SMEQ 与 UME 分数存在 r=0.84 的强相关。

SMEQ 问卷内容为:

问卷标签翻译成中文为:极其难做,非常非常难做,非常难做,相当难做,难做,有些难做,有一点难做,不是很难做,一点也不难做。

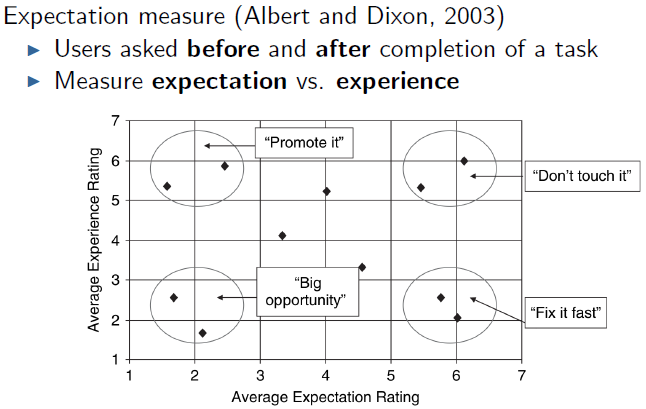

期望评分 ER

期望评分(Expactation Ratings,ER)由 Albert & Dixon(2003)发表,他们认为任务的难度是与用户进行任务前的预期难度相关的。因此,ER 包括两个项目:一个在进行任务前施测,另一个在任务后施测:

- 在进行所有任务之前(期望评分):“你预期这个任务的难易度如何?”

- 完成每个任务后(经验评分):“你觉得这个任务的难易度如何?”

ER 的项目采用从 1(非常容易)到 7(非常困难)的 7 点评分。与其它问卷比较最终得分的解释方法不同,ER 的分数解释通过预期分数和体验分数两个维度构成的象限图来完成。如下:

四象限分别代表的意思为:值得推广、改进机会、保持状态、急待改进

可用性等级评估 UME

可用性等级评估(Usability Magnitude Estimation,UME)由 McGee(2003)发表,是仅包括一个项目的定比测量。Jeff Sauro and Dumas (2009) 的研究推荐了一种更方便解释和施测的方法,即为 UME 的评分定义基线。在研究中,他们将一个图标搜索任务的难度定义为 10,被测者对任何测试任务的难度评估均以 10 标准点得出。

与其它任务后测量问卷不同,UME 并不限定被测者的作答区间,可以是从绝对零值到正无限的任意值。这意味着 50 分的任务就是比 25 分的任务困难 2 倍,为解释结果提供了便利。对于 UME 的使用,目前仍存在着诸多争议。与其它问卷相比,UME 更加依赖于主试人员;不同被试对基线的理解存在差异;训练被试理解‘两倍难度’,‘一半难度’等概念也会增加测试成本和误差。

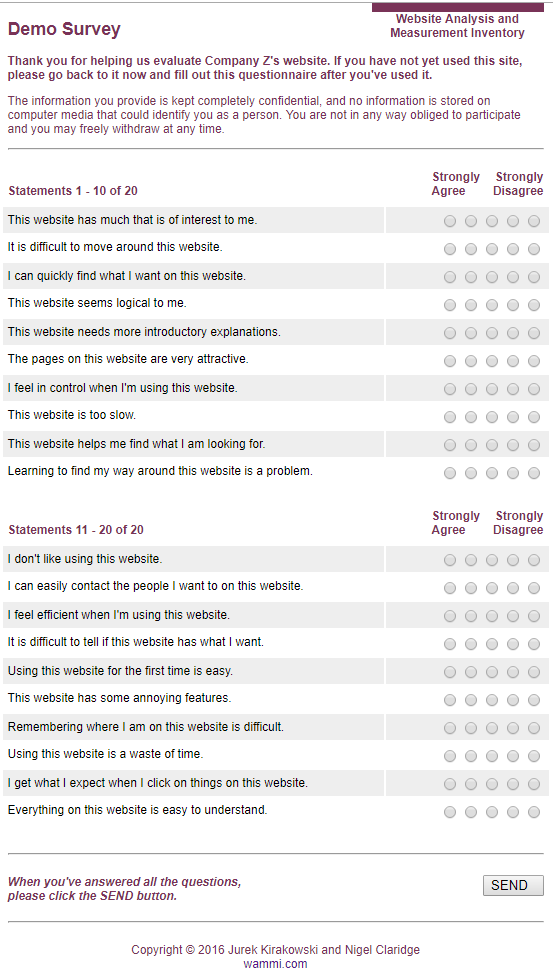

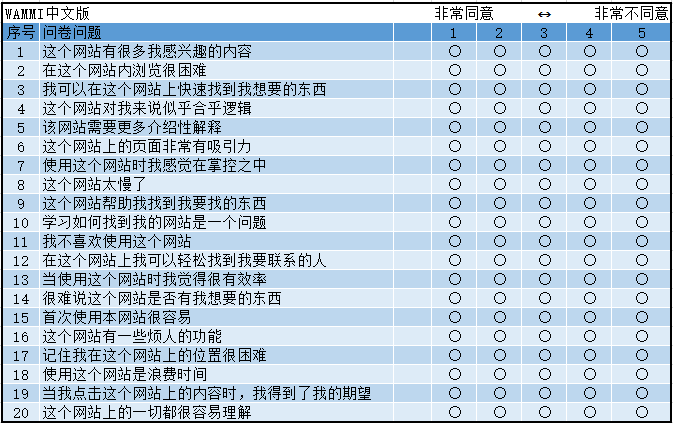

网站分析和测量量表 WAMMI

第一个意识到需要一个专门用来评估网站质量工具的是爱尔兰科克大学的人因研究小组(HFRG),他们与斯德哥尔摩的 Nomos Management AB 合作,他们创建了网站分析和测量问卷(Website Analysis and Measurement Inventory,WAMMI)。WAMMI 包括 20 个项目,测量的因子与 SUMI 相同。WAMMI 的总体信度在 0.9-0.93 之间,几个因子的测试信度为吸引力:0.64;可控性 0.69;效率:0.63;帮助性:0.7;易学性:0.74。相对于其它量表,这些分量表的信度有点儿偏低,因此 WAMMI 对于样本量有比较严格的规定:可用性测试不少于 30 人,学术应用不少于 100 人。

全部项目采用从 1(强烈同意)到 5(强烈不同意)的 5 点评分。在进行分数解释时,WAMMI 推荐生成各个分量表的分数以及一个总分。其分数的标准化方式暂无公开发表,但标准化 WAMMI 分数的平均值为 50,标准差为 10。

该工具对教育用途是免费的,但是对于商业用途需要收费,但是WAMMI 的网站上行只列出了联系方式没有具体的费用。

WAMMI 中文版:

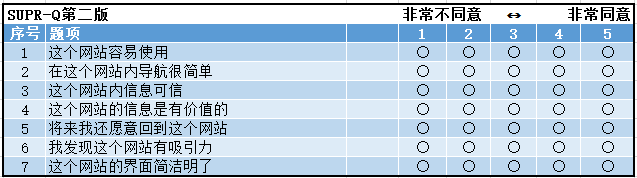

标准通用的百分等级量表 SUPR-Q

标准通用的百分等级量表(Standardized Universal Percentile Rank Questionnaire,SUPR-Q)是一个等级量表,根据官网的信息,SUPR-Q 总共包括 10 个项目,分别测量网站的可用性(Usability),可信度/信任(Trust & Credibility),外观(Appearance)和忠诚度(Loyalty)。

- The website is easy to use. (usability)

- It is easy to navigate within the website. (usability)

- The information on the website is credible (trust for non-commerce)

- The information on the website is trustworthy (trust for non-commerce)

- I feel comfortable purchasing from the website. (trust for commerce sites)

- I feel confident conducting business on the website. (trust for commerce sites)

- I will likely visit this website in the future (loyalty)

- I find the website to be attractive. (appearance)

- The website has a clean and simple presentation. (appearance)

- How likely are you to recommend this website to a friend or colleague? (loyalty)

《用户体验度量》这本书上给出的题项是 8 个其中 7 个项目是 5 分制,第 8 个项目(NPS)是 11 分值。具体如下:

计算分值时,将前七个问题的答案加上第八个项目于的一半分数加起来即可。

SUPR-Q 的总体信度为 0.86。SUPR-Q 分量表的可信度为:

- 可用性(项目 1,2):88

- 信任度(项目 3,4):85

- 忠诚度(项目 5,8):64

- 外观(项目 6,7):78

需要说明的是,SUPR-Q 并不是免费的,具体价格为:

- 1999 美元的商业许可证,可以访问规范数据库

- 标准个人拍照 499 美元

- 学生和学者享受折扣优惠

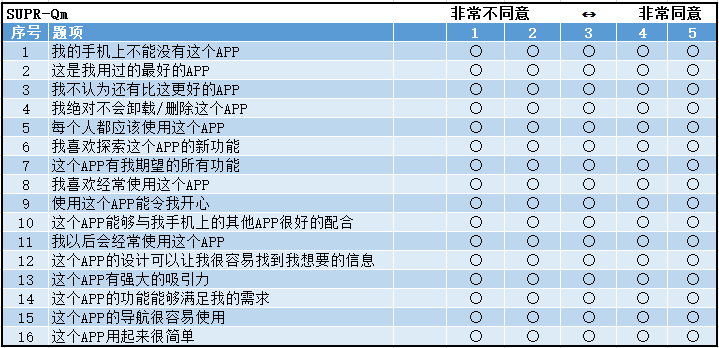

APP 用户体验量表:SUPR-Qm

SUPR-Qm 由 SUPR-Q 的作者 Jeff Sauro 创建,主要目的是面向一定 APP 做用户调研。

SUPR-Qm的来源

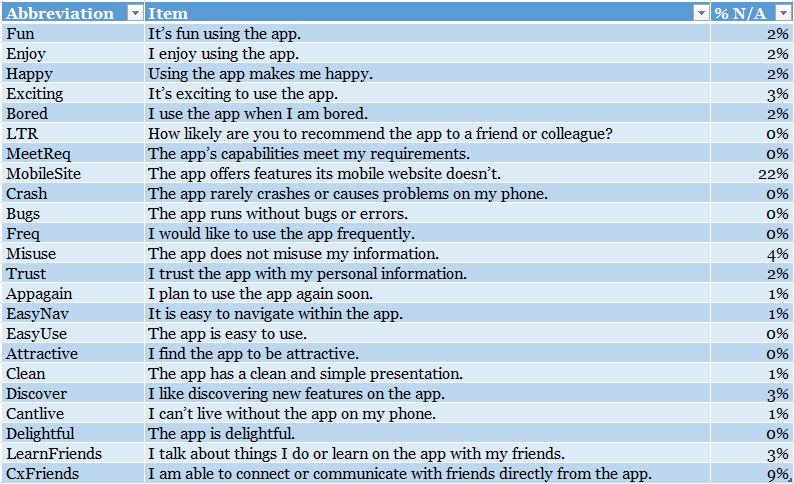

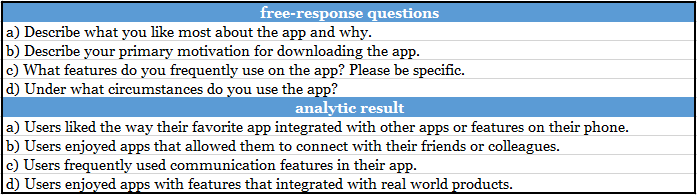

SUPR-Qm来源于最23个其他相关文献中的题目和4个开放性的问题。

23个相关题目

翻译成中文:

4个开放性问题

翻译成中文:

具体中间是如何去设计问卷的,可以参考文章后面的参考链接了解更多。

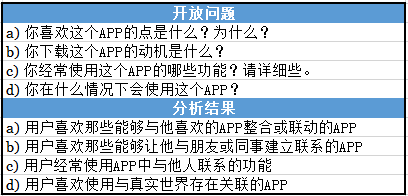

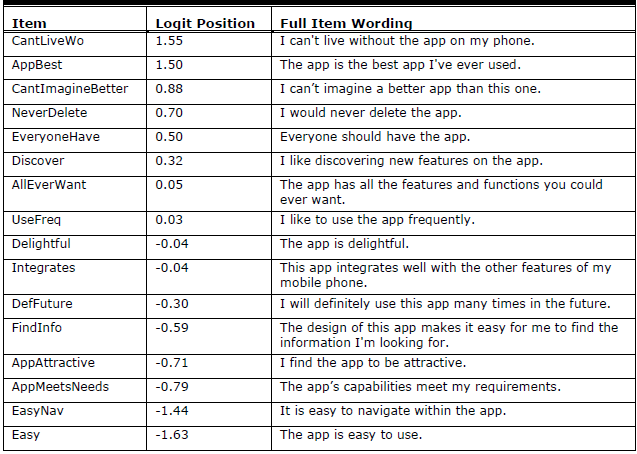

SUPR-Qm的问卷内容

通过对上面的一些内容的综合分析,得出的SUPR-Qm的最终问卷内容为:

上图中的LogitPosition为获得此项高分的难易程度,数值越高代表越难。

翻译成中文:

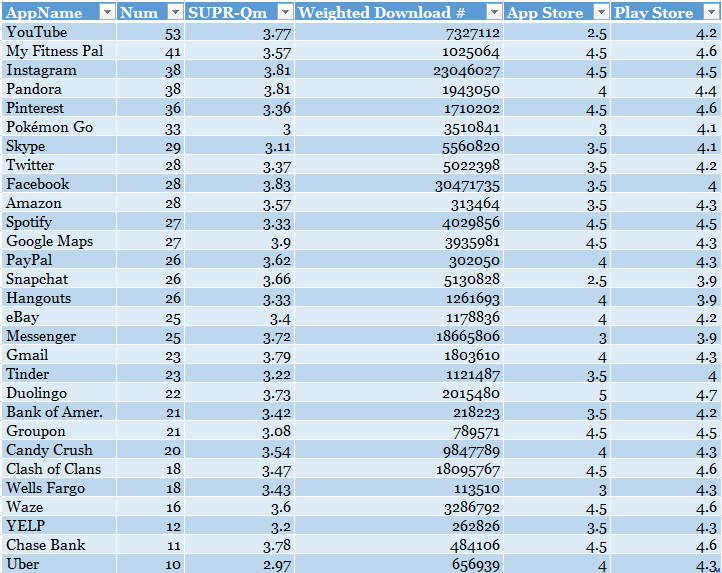

SUPR-Qm的内部一致性信度达到0.94,与其它体验量表的得分有着显著的相关性:与LTR(推荐度)的相关性为0.74、与SUPR-Q相关性为0.71、与UMUX-Lite的相关性为0.74。同样的,SUPR-Qm的分数与Apple Store和Google Store的用户评分之间有0.38的相关性。

SUPR-Qm的适用场景

- 在可用性测试中或者网络投放的回忆性测试中评估APP的整体性用户体验,作为之后产品提升或改变的基线对比

- 在可用性的前后分别进行施测,以便于进行对比分析产品的优化成果

- SUPR-Qm可以和其它具有领域特殊性的问题混合在一起使用,以便于测量某些特殊产品(如游戏)的用户体验

另外,在验证SUPR-Qm信效度时,Sauro评估了国外比较常用的一部分APP,有需要的也可以用这些去做对比,如下:

参考链接:

电脑系统可用性问卷CSUQ

电脑系统可用性问卷(Computer System Usability Questionnaire,CSUQ)是PSSUQ的一种变形。在发表PSSUQ之后,为了适应非实验室测试的测验环境,Lewis更改了其措辞编制了CSUQ。因此,CSUQ在项目数,计分方式等方面与PSSUQ是一模一样的。如果要在PSSUQ和CSUQ间作选择,则在实验室测试是选择PSSUQ,而在非实验室的测试环境时选择CSUQ。

CSUQ的总体信度为0.95,系统质量的信度为0.93,信息质量的信度为0.89,界面质量的信度则是0.89(Lewis, 1995)。

英文版CSUQ:

中文版CSUQ:

《用户体验度量》这本书上删除了上述黄色标注的3个选项(为的是与PSSUQ版本3一致)

PSSUQ的分量表的计算方式为:

- 整体:题项1~16的反应平均值

- 系统质量:题项1~6的平均值

- 信息质量:题项7~12的平均值

- 界面质量:题项13~15的平均值

书上没有明确说明CSUQ如何计算,初步看了下,PSSUQ的计算方式应该可以拿来使用。

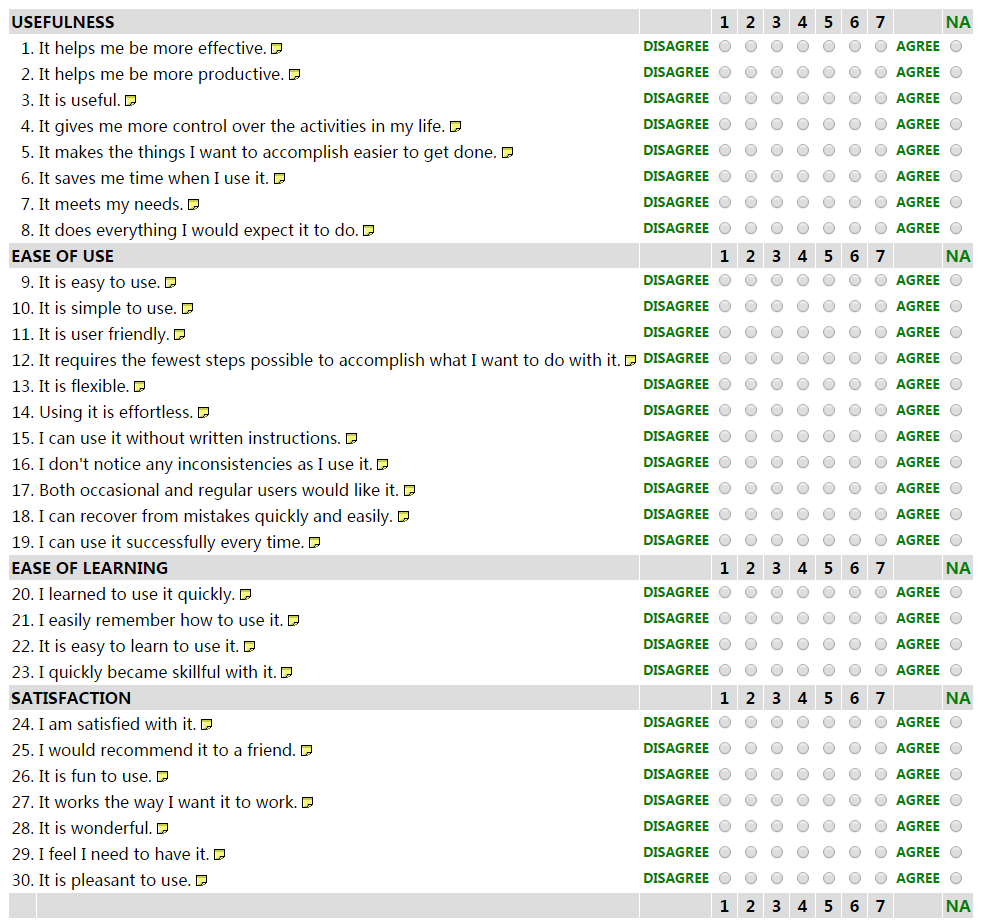

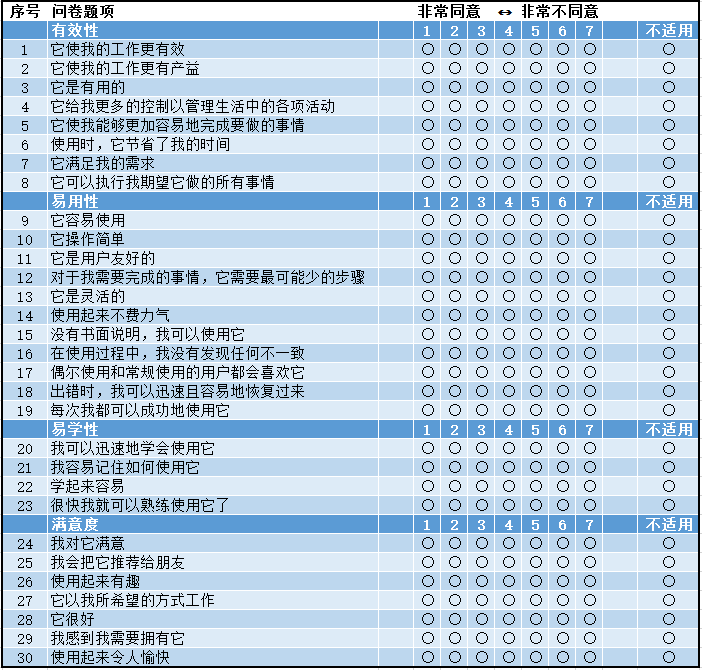

有用性、满意度、易用性量表USE

Arnie Lund(2001年)发表了USE量表。测试4个部分,总共包括30个项目。其中的有效性(Usefulness)包括8个项目,易用性(Ease of Use)包括11个项目,易学性(Ease of Learning)包括4个项目,满意度(Satisfaction)包括7个项目。

量表的全部项目都是从1(不同意)到7(同意)的7点评分。其具体的统计方式和统计学参数尚未公开发表。但使用者可通过建立基线/竞品对比等方式来评测产品的可用性表现。

量表链接:http://garyperlman.com/quest/quest.cgi?form=USE

翻译成中文的USE:

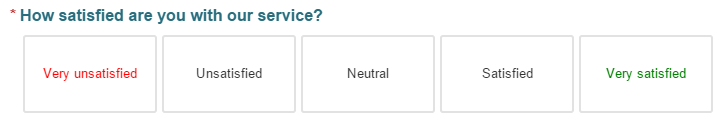

客户满意度CAST(Customer Satisfaction Score)

CAST应该是最经典的衡量指标。CSAT要求用户评价对特定事件/体验的满意度,使用的是五点量表(非常满意、满意、一般、不满意、非常不满意。)。通过计算选择4分和5分的用户所占比例得出最终的CSAT值。CSAT的好处是简单且扩展性强,它只有一个问题,但是针对每个我们感兴趣的功能或服务,我们都可以设定一个CSAT题项进行测量。

目前很多网站或APP的点评功能基本上都是参照CSAT创建的。CSAT的好处是简单且扩展性强。CSAT这个衡量指标也存在以下几个问题:

- 如果无法引导客户真正参与评分,样本结果很可能无法给企业带来真实的反馈。

- 满意度并不直接与客户忠诚度相关联。

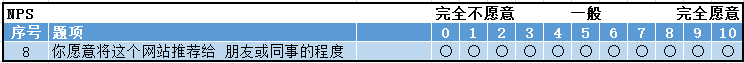

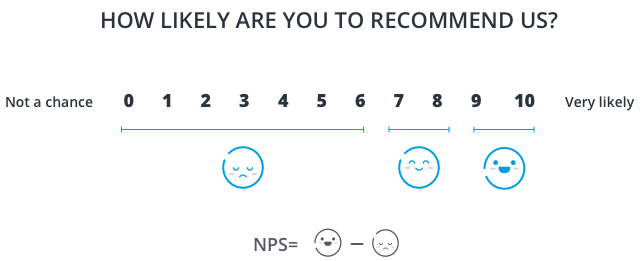

净推荐值 NPS(Net Promoter Score)

净推荐值最早是由贝恩咨询企业客户忠诚度业务的创始人佛瑞德·赖克霍徳(Fred Reichheld)在 2003 提出,它通过测量用户的推荐意愿,从而了解用户的忠诚度。NPS 并非一个单独的量表,它的问题项目来源于 SUPR-Q。做净推荐值的调研比较简单,只需要一个问题:”您是否会愿意将 XXX(企业或者产品)推荐给您的朋友或者同事吗?”然后根据愿意推荐的程度让客户在 0~10 之间打分并根据得分情况来判断三种客户:

- 推荐者 Promoters(得分在 9~10 之间):是具有狂热忠诚度的人,他们会继续购买并引荐给其他人

- 被动者 Passives(得分在 7~8 之间):总体满意但并不狂热,将会考虑其他竞争对手的产品

贬损者 Detractors(得分在 0~6 之间):使用并不满意或者对你的企业没有忠诚度

推荐者所占比例减去贬损者所占比例就是最终的 NPS 值。NPS 询问的是意愿而不是情感,对用户来说更容易回答,且相比于 CSAT,它对用户行为的预测力更高。

- 优势:NPS 仅需要用户回答一个简单的问题,比较容易完成,因此用户会更愿意参与评分。

- 劣势:NPS 面临最主要的批判是只有一个问题,那就意味着只能测量一个维度,因此它仅提供了一个狭窄的用户满意度视角。而且,这个问题也不能证明推荐者会真的向他们生活中的朋友推荐企业的产品或服务,因此这个分数并不一定与客户在现实生活中的推荐行为相关。

客户费力度 CES(Customer Effort Score)

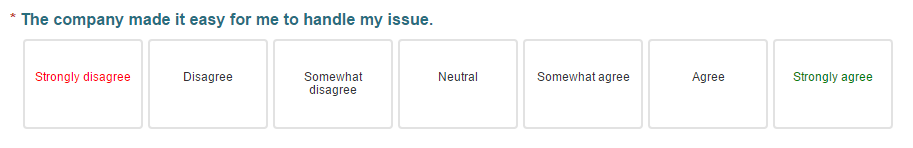

客户费力度这个概念在 2010 年在《哈佛商业评论》中被提出,按字面意思理解,”客户费力度”是让用户评价使用某产品/服务来解决问题的困难程度。第一版的”客户费力度”的问题是:为了得到你想要的服务,你费了多大劲儿?(How much effort did you personally have to put forth to handle your request?),用户需要在 1 分(very low effort)到 5 分(very high effort)之间做出选择。

CES 的理念是只有真正帮助用户轻松地解决问题的产品或服务,才会获得高满意度和忠诚度。最好在用户刚刚做完操作时询问,否则用户可能忘记自己完成操作的实际体验。下图是现在比较通用的 2.0 版本:

- 提出的问题是:企业让我的问题处理过程变得简单。

- 客户的选项包括:强烈不同意,不同意,有点不同意,中立,有点同意,同意,强烈同意

度量:计算所有用户的答案的总和,得到的总分低说明企业降低了用户满足需求的难度,而总分很高则说明用户在与企业互动的时候花费了太多力气。

- 优势:CES 的优势之一是只关注”用户费力程度”这个要素的解决办法。计算 CES 分数的唯一目的是消除或减少用户服务中的障碍。CES 已被证实是评估用户忠诚度的最佳指标。

- 劣势:CES 可以指出用户服务中的障碍,但它并不会深究为什么用户会遇到问题,或这些障碍会是什么。

技术接受模型 TAM

技术接受模型(Technology Acceptance Model,TAM)是由美国学者戴维斯(Fred D. Davis, 1986)根据理性行为理论(Theory of Reasoned Action,简称 TRA)在信息系统/计算机技术领域发展而来,用于解释和预测人们对信息技术的接受程度。

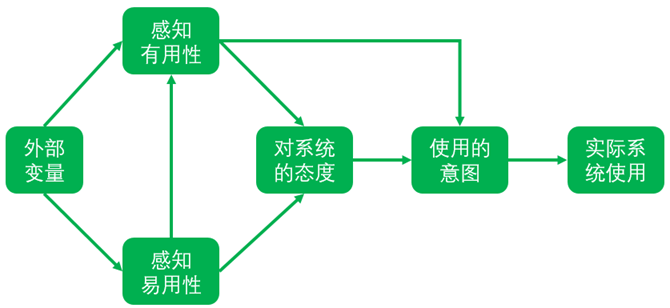

技术接受模型主张,人对信息科技的使用受其行为意图的影响,用来探讨外部因素对使用者的内部信念(beliefs)、态度(attitudes)及意向(intentions)的影响,两者进而影响信息系统使用的情况(Davis, 1989)。该理论认为,当用户面对一个新的技术时,感知有用性和感知易用性是两个主要的决定因素,如下图所示。

技术接受模型

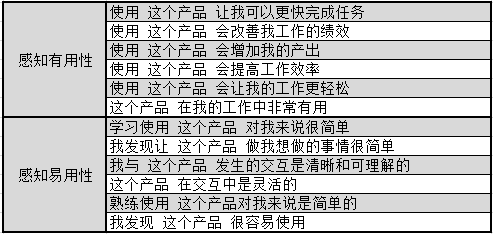

- 感知易用性(Perceived ease-of-use,简称 PEOU):指使用者认知到科技容易使用的程度,当系统越容易使用时,使用者对于自我效能与自我控制会更具信心,对系统所持态度也会更积极。

- 感知有用性(Perceived usefulness,简称 PU):指使用者相信使用某系统会增加其工作绩效或所能省下努力的程度。使用者认知系统容易被使用时,会促进使用者以相同的努力完成更多的工作,因此认知有用同时受到认知易用与外部变量的影响。

用户的感知易用性越高,其使用态度倾向越积极。同时用户的感知易用性越高,其感知有用性也越大。

TAM 问卷内容

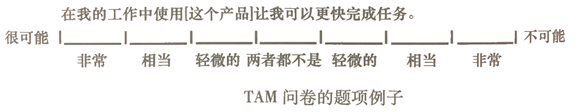

TAM 的题项采用 7 个步距,从”很可能”到”不可能”,每个都是文字标签而非数字标签。示例:

具体题项为:

总结:这个调查问可能更加适合工具类的软件或应用。对于娱乐类的应用在评判有用性方面可能存在一定的不适用。

享受性质量 HQ

为了支持非任务相关方面的用户体验研究,Hassenzahl 等(2002)开发了一份评估享受性质量(Hedonic Quality, HQ)的问卷。HQ 有 7 个 7 点双极的题项。具体如下:

- HQ1:有趣的–无趣的

- HQ2:昂贵的-便宜的

- HQ3:激动人心的-令人沉闷的

- HQ4:独有的–标准的

- HQ5:印象深刻的–不伦不类的

- HQ6:独创的–普通的

- HQ7:创新的–保守的

HQ 的调查问卷非常的简单,但是对于其问卷的角度,与其他问卷还是有较大的差异,从问题的内容看,这个比较使用于商品的评价,先记着,以便后期有可能用到。

微软产品反应卡片

微软产品反应卡片 Microsoft Reaction Card Method (Desirability Testing)是由微软公司的 Joey Benedek 和 Trish Miner 于 2002 年推出的一种测试”合意性”的方法。该方法主要用于检查设计或产品的情绪反应和合意性,通常应用在软件设计领域。

要求参与者基于 118 个单词的列表来描述设计/产品。每个单词都放在一张单独的卡片上。观看设计或产品后,参与者被要求挑选他们认为相关的词语。主持人然后会要求参与者描述他们选择的理由。

| The complete set of 118 Product Reaction Cards | ||||

| Accessible | Creative | Fast | Meaningful | Slow |

| Advanced | Customizable | Flexible | Motivating | Sophisticated |

| Annoying | Cutting edge | Fragile | Not Secure | Stable |

| Appealing | Dated | Fresh | Not Valuable | Sterile |

| Approachable | Desirable | Friendly | Novel | Stimulating |

| Attractive | Difficult | Frustrating | Old | Straight Forward |

| Boring | Disconnected | Fun | Optimistic | Stressful |

| Business-like | Disruptive | Gets in the way | Ordinary | Time-consuming |

| Busy | Distracting | Hard to Use | Organized | Time-Saving |

| Calm | Dull | Helpful | Overbearing | Too Technical |

| Clean | Easy to use | High quality | Overwhelming | Trustworthy |

| Clear | Effective | Impersonal | Patronizing | Unapproachable |

| Collaborative | Efficient | Impressive | Personal | Unattractive |

| Comfortable | Effortless | Incomprehensible | Poor quality | Uncontrollable |

| Compatible | Empowering | Inconsistent | Powerful | Unconventional |

| Compelling | Energetic | Ineffective | Predictable | Understandable |

| Complex | Engaging | Innovative | Professional | Undesirable |

| Comprehensive | Entertaining | Inspiring | Relevant | Unpredictable |

| Confident | Enthusiastic | Integrated | Reliable | Unrefined |

| Confusing | Essential | Intimidating | Responsive | Usable |

| Connected | Exceptional | Intuitive | Rigid | Useful |

| Consistent | Exciting | Inviting | Satisfying | Valuable |

| Controllable | Expected | Irrelevant | Secure | |

| Convenient | Familiar | Low Maintenance | Simplistic | |

翻译成中文为:

| 完整的一套反应卡:118张 | ||||

| 易接近的 | 有创造性的 | 快速的 | 有意义的 | 慢的 |

| 高级的 | 定制化的 | 灵活的 | 鼓舞人心的 | 复杂的 |

| 烦人的 | 前沿的 | 易坏的 | 不安全的 | 稳定的 |

| 有吸引力的 | 过时的 | 生气勃勃的 | 没有价值的 | 缺乏新意 |

| 可接近的 | 值得要的 | 友好的 | 新颖的 | 刺激的 |

| 吸引人的 | 困难的 | 挫败的 | 陈旧的 | 直截了当的 |

| 令人厌烦的 | 无条理得的 | 有趣的 | 乐观的 | 紧迫的 |

| 有条理的 | 引起混乱的 | 障碍的 | 普通的 | 费时间的 |

| 犯罪的 | 令人分心的 | 难以使用 | 专横的 | 过于技术化 |

| 干净利落的 | 易于使用 | 高品质 | 不可抗拒的 | 可信赖的 |

| 清除的 | 有效的 | 无人情味的 | 要人领情的 | 不能接近的 |

| 合作的 | 能干的 | 令人印象深刻的 | 私密的 | 不引人注意的 |

| 舒适的 | 不费力气的 | 不能理解的 | 品质糟糕的 | 无法控制的 |

| 兼容的 | 授权的 | 不协调的 | 强大的 | 非传统的 |

| 引人注目的 | 有力的 | 效率低的 | 可预知的 | 可懂的 |

| 复杂的 | 迷人的 | 创新的 | 专业的 | 令人不快的 |

| 全面的 | 使人愉快的 | 令人鼓舞的 | 中肯的 | 不可预知的 |

| 可靠的 | 热情的 | 综合的 | 可信的 | 未精炼的 |

| 令人糊涂的 | 精华的 | 令人紧张的 | 反应迅速的 | 可用的 |

| 连贯的 | 异常的 | 直觉的 | 僵化的 | 有用的 |

| 一致的 | 令人兴奋的 | 引人动心的 | 令人满意的 | 有价值的 |

| 可控的 | 期盼的 | 不切题的 | 安全的 | |

| 便利的 | 熟悉的 | 低消耗的 | 过分简单化的 | |

通过分析参与者的结果数据,研究者可以将特定的形容词和每个视觉设计方案结合起来,并且评估哪个方案与企业试图唤起的情感反应和品牌属性更加符合。研究者可以在一对一的情境中或者问卷调查中使用这个方法。一对一的方法的好处是研究者可以询问用户为什么选择特定的形容词,这个过程可能会发现一些额外的洞见。

在这里,合意性研究能够帮助解决两个问题:

- 告知设计团队,为什么不同的设计方向能够引发目标用户特定的反应(为了完善设计方向)

- 精确测量针对特定形容词(如,品牌特性)的视觉设计方向,从而帮助做出最后决策

参考链接:

- Using the Microsoft Desirability Toolkit to Test Visual Appeal

- Desirability Studies: Measuring Aesthetic Response to Visual Designs

主观性工作负荷评估技术 SWAT

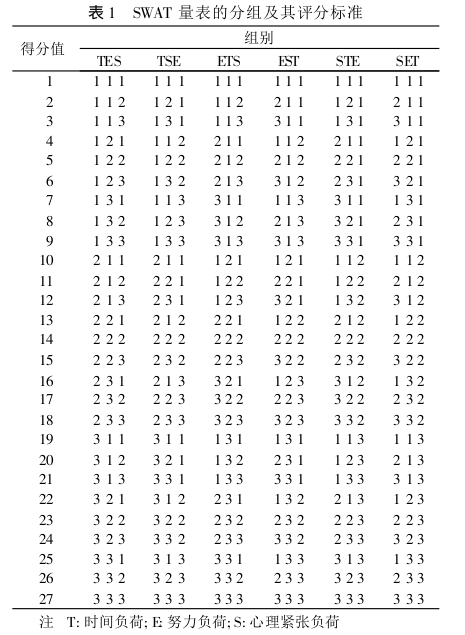

SWAT 的指标体系中包含三个指标:

- 时间负荷 (Time Load,记为 T),反映工作过程中产生的焦虑、不称心等心理变化的程度。

- 努力负荷 (Effort Load,记为 E),反映工作过程中可用空闲时间的多少。

- 心理紧张负荷 (Psychological Stress Load,记为 S),反映工作过程中需要付出多大努力来完成此作业任务。

调查对象先对这3个条目的重要性进行排序。根据排序的不同结果,将调查对象分到不同的组别。如某一调查对象认为时间最重要,努力其次,心理紧张最后,则相应的组别为TES(即TimeLoad>EffortLoad>PsychologicalStressLoad);若努力最重要,时间第二,则相应的组别为ETS。

接下来,调查者需要根据自己的实际情况选择每一指标的相应等级,每个指标均分为轻、中、重3个等级,分别用1,2,3表示,量表对三个指标的各等级都有详细的文字说明:

- 时间负荷

- 经常存在多余时间且受到外界干扰较少

- 偶尔存在多余时间,有时会受到外界干扰

- 经常感觉时间不够用且经常受到外界干扰

- 努力负荷

- 只需要付出很少的努力,就能完成指定任务

- 需要付出一定努力,才能完成指定任务

- 必须付出很大的努力,才能将任务勉强完成

- 心理紧张负荷

- 心情较为压抑,有些焦虑,不开心,但是依然愿意完成作业任务

- 情绪开始波动、烦躁起来,对于工作要求没有那么严格,需要采取相应辅导才能完成任务

- 情绪激动,产生恐惧感,迫切希望停止工作

评价时,研究者先根据排序情况将调查对象归入表1中的6个组别,然后根据每个条目相应的等级从表1中查出分值,再换算为0~100分,分值越大,负荷越重。

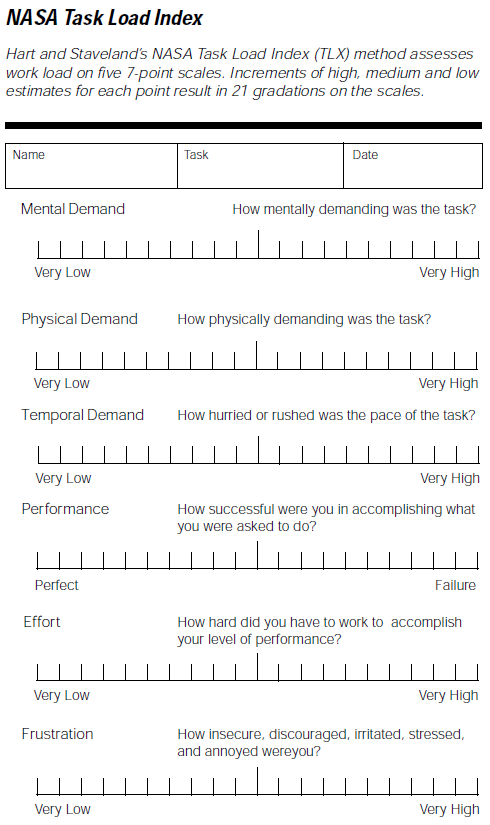

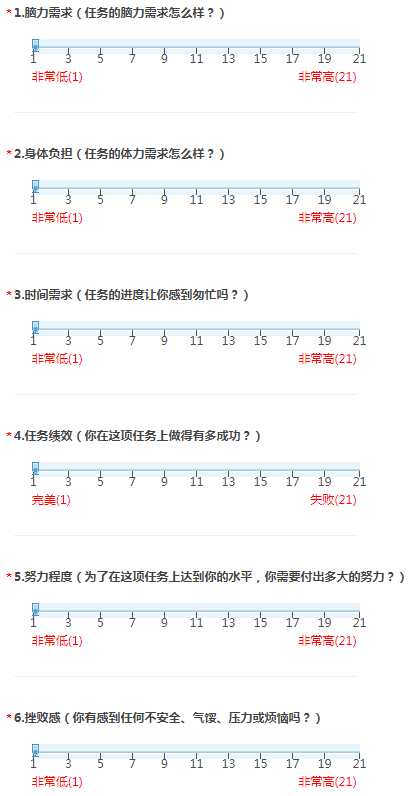

NASA任务负荷问卷NASA-TLX

NASA任务负荷问卷(NASA-TLX, NASA Task Load Index)是一个主观的工作量评估工具,主要用途是对各种人机接口系统的操作人员进行主观的工作量评估。通过采用多维评级程序,美国国家航空航天局TLX根据六个加权平均数的评级得出总体工作量评分:

- 脑力需求(Mental Demands)

- 身体负担(Physical Demands)

- 时间需求(Temporal Demands)

- 任务绩效(Own Performance)

- 努力程度(Effort)

- 挫败感(Frustration)

当前版本的NASA-TLX:

翻译成中文为:

调查过程主要有三步:

标准的TLX施测程序包括两部分:

- 用户需要在每两个项目之间进行选择以判断任务负荷的来源(共15对),以确定各个项目在任务负荷中构成的权重:

- 调查对象首先依据自身感受判断工作负荷的来源,对六个指标的重要程度进行两两对比(共15组对比),判断各指标对工作负荷的重要程度。根据指标被优先选择的次数,决定各指标的权重。每个指标的权重都在0-5之间,所有指标的权重加起来必须等于15。

- 分别对每个因素的状况进行打分评定,求得各因素的评估值,打分均在0-100之间。

- 结合各指标的分值和权重,作加权平均,计算出综合的工作负荷值。

- 在6个项目上进行的10点语义差异评分(用户在刻度上打分,处于两格之间的分数取靠右的值)。将项目的权重和项目评分相乘即为该用户的TLX分数。当然,在正式使用时,也有研究省略掉权重评估的部分直接计算项目得分。

官方网站:

官方网站: