文章内容如有错误或排版问题,请提交反馈,非常感谢!

Pandera简介

Pandera是一个用于验证、清理和文档化Pandas数据框架(DataFrame和Series)的Python库。它提供了基于类型注释的方式来定义数据验证规则,确保数据符合预期格式和约束。这对于数据管道的构建、数据清理以及增强代码的健壮性和可维护性非常有用。

Pandera的核心功能

- 数据验证:

- 验证数据是否符合指定的格式、范围和统计特性。

- 通过预定义的架构对输入数据进行自动检查。

- 数据清理:自动修正部分数据错误,例如类型转换、缺失值处理等。

- 文档化数据模型:通过声明式API明确数据模型,便于团队协作和代码维护。

- 与Pandas和PySpark集成:支持Pandas数据框验证,也支持PySpark数据验证(通过扩展)。

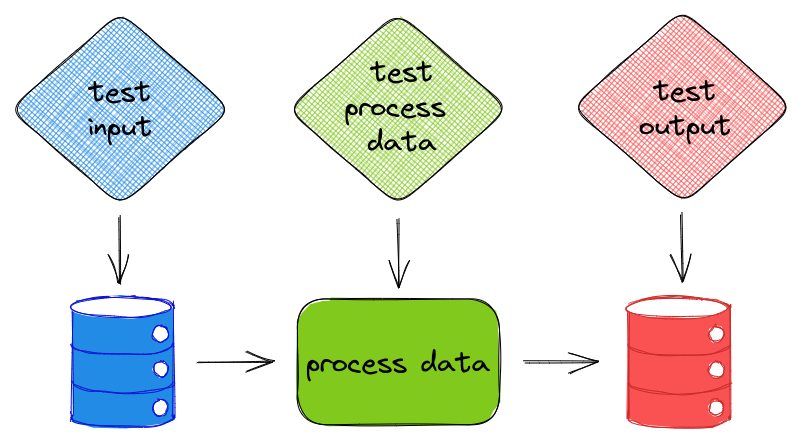

- 动态管道验证:可嵌入到ETL或数据管道中,在数据进入后端或存储前保证质量。

Pandera的优势

- 强类型验证:提供类似于静态类型检查工具的功能,防止运行时错误。

- 灵活的自定义规则:允许开发者为特定业务逻辑定义复杂约束。

- 与现有生态系统无缝集成:兼容Pandas数据框和PySpark数据框。

- 提高代码可读性和可维护性:通过明确的数据模型定义减少团队沟通成本。

Pandera的不足

- 性能开销:在大规模数据验证场景下可能会带来额外的性能开销。

- 学习曲线:对于不熟悉数据验证或Pandas的用户可能需要一定时间熟悉。

- 功能限制:不直接支持数据库数据验证,需要与其他工具(如SQLAlchemy)结合使用。

使用场景

- 数据质量管控:在数据管道的每个环节验证数据质量,防止下游错误。

- ETL数据验证:确保从外部源导入的数据符合预期。

- 机器学习前数据处理:确保训练数据集符合特定的格式和分布要求。

- 数据清洗和修复:自动修复简单的数据问题,提高数据管道的健壮性。

Pandera的使用

Pandera的安装

可以通过pip安装Pandera:pip install pandera

对于需要支持PySpark的功能,可以使用:pip install pandera[spark]

核心概念

Schema定义

Pandera使用DataFrameSchema和Column对数据框和列进行约束。

示例:定义一个简单的数据框架架构

import pandera as pa

from pandera import Column, DataFrameSchema, Check

# 定义数据框架架构

schema = DataFrameSchema({

"name": Column(str, nullable=False), # 必须是字符串,不能为空

"age": Column(int, Check(lambda x: 0 <= x <= 120)), # 年龄在0-120之间

"email": Column(str, Check.str_matches(r"[^@]+@[^@]+\.[^@]+")), # 合法的email格式

"salary": Column(float, Check.greater_than_or_equal_to(0)) # 工资必须非负

})

验证数据

import pandas as pd

# 创建一个Pandas数据框

data = pd.DataFrame({

"name": ["Alice", "Bob", "Charlie"],

"age": [25, 35, -5], # 错误:age -5不符合规则

"email": ["alice@example.com", "bob@", "charlie@example.com"], # 错误:bob@格式不合法

"salary": [50000.0, -10000.0, 75000.0] # 错误:salary为负

})

# 验证数据

try:

schema.validate(data)

except pa.errors.SchemaError as e:

print(e)

动态检查(Check对象)

Check对象提供了多种预定义检查和自定义检查能力。

示例:常见检查

Check.greater_than(0) # 值大于0 Check.less_than(100) # 值小于100 Check.str_length(min_value=5, max_value=10) # 字符串长度范围 Check.isin(["A", "B", "C"]) # 值必须在列表中 Check.unique() # 保证列值唯一

示例:自定义检查

def custom_check(x):

return x % 2 == 0 # 检查是否为偶数

Column(int, Check(custom_check))

灵活性支持

- 可选列:如果某列可能不存在,可以设置required=False。

- 动态架构生成:允许根据输入动态生成架构规则。

与Pandas的集成

Pandera与Pandas的集成非常紧密,允许直接在Pandas数据操作中验证和清理数据。

示例:链式调用

import pandera.extensions as pa_ext

@pa_ext.register_dataframe_accessor("validate")

class ValidateDataFrameAccessor:

def __init__(self, pandas_obj):

self._obj = pandas_obj

def validate_schema(self, schema):

return schema.validate(self._obj)

data.validate.validate_schema(schema)

高级功能

支持多索引数据

Pandera支持验证多层索引的Pandas数据框:

schema = pa.DataFrameSchema(

index=pa.MultiIndexSchema([

pa.Index(int, name="id"),

pa.Index(str, name="category")

])

)

数据清理

Pandera可以在验证失败时尝试修正数据:

schema = pa.DataFrameSchema( {"age": Column(int, pa.Check(lambda x: x >= 0, element_wise=True, on_error="coerce"))} ) clean_data = schema.validate(data)与 PySpark 集成

Pandera 通过扩展支持对 Spark DataFrame 进行验证:

from pandera.typing import DataFrame @spark_schema def validate_spark_dataframe(df: DataFrame): ...实际应用案例

示例:金融数据验证

schema = DataFrameSchema({ "account_id": Column(int, Check.greater_than(0), unique=True), "balance": Column(float, Check.greater_than_or_equal_to(0)), "transaction_date": Column("datetime64[ns]", nullable=False), }) financial_data = pd.read_csv("transactions.csv") validated_data = schema.validate(financial_data)示例:机器学习数据集验证

from sklearn.model_selection import train_test_split data_schema = DataFrameSchema({ "feature1": Column(float, Check.greater_than(0)), "feature2": Column(float, Check.less_than(1)), "target": Column(int, Check.isin([0, 1])) }) validated_data = data_schema.validate(data) X_train, X_test, y_train, y_test = train_test_split( validated_data[["feature1", "feature2"]], validated_data["target"], test_size=0.2 )参考链接: