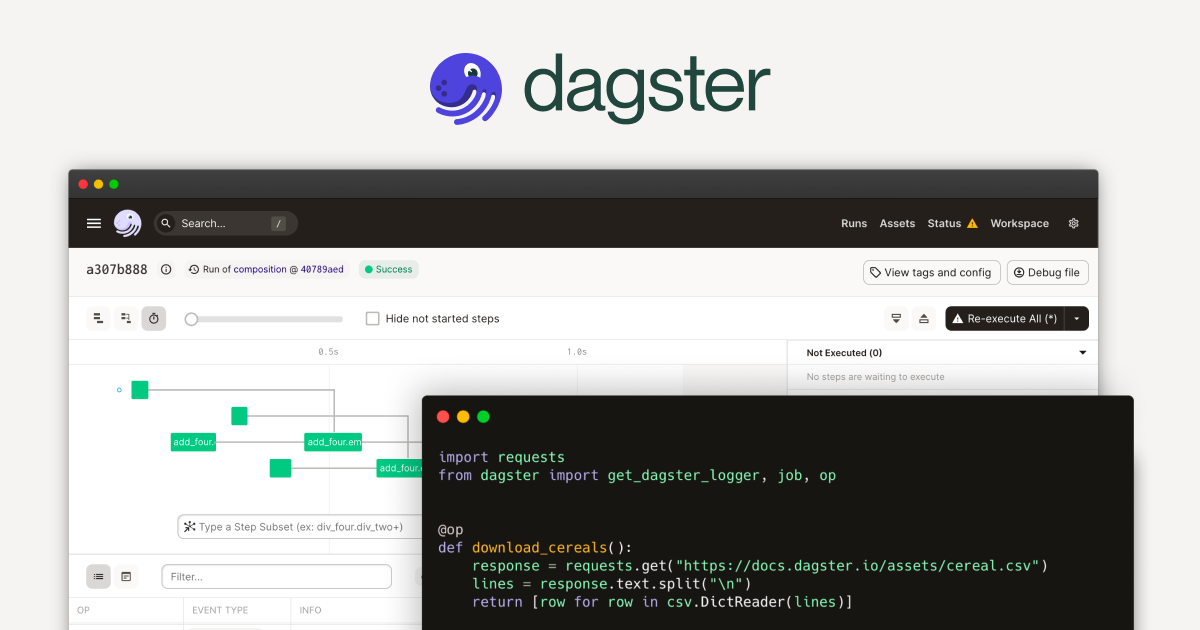

Dagster简介

Dagster是一个开源的数据工作流编排工具,专注于数据管道的开发、测试、监控和维护。它旨在帮助数据工程师和数据科学家构建可靠且可扩展的数据管道。

核心概念

- Pipeline(管道):在Dagster中,管道是由多个操作(Operation)或步骤(Step)组成的数据处理工作流。管道定义了数据如何在不同的步骤之间流动。

- Solid(实体):实体是Dagster中的基本执行单元,类似于任务或函数。每个实体可以接收输入并产生输出,实体之间通过输入和输出连接形成管道。

- DagsterType(类型):Dagster支持用户定义的数据类型,以确保数据在管道中的正确性和一致性。类型系统可以帮助捕获错误和进行数据验证。

- Mode(模式):模式定义了管道的执行环境和资源配置。例如,不同的模式可以定义不同的资源管理方式,如本地执行或云端执行。

- Resource(资源):资源是管道执行过程中需要的外部依赖,如数据库连接、缓存系统等。资源管理可以通过模式进行配置。

- Partition(分区):Dagster支持对管道进行分区,以便在不同的数据子集上并行执行。这对于处理大规模数据集和定期任务非常有用。

功能特点

- 开发和测试友好:Dagster提供了一种函数式编程风格来定义管道,使得代码更具可读性和可维护性。同时,它支持强类型和数据验证,帮助开发人员捕获潜在错误。

- 灵活的调度和执行:支持定期调度和事件驱动执行,可以通过不同的模式配置执行环境,适应多种运行环境。

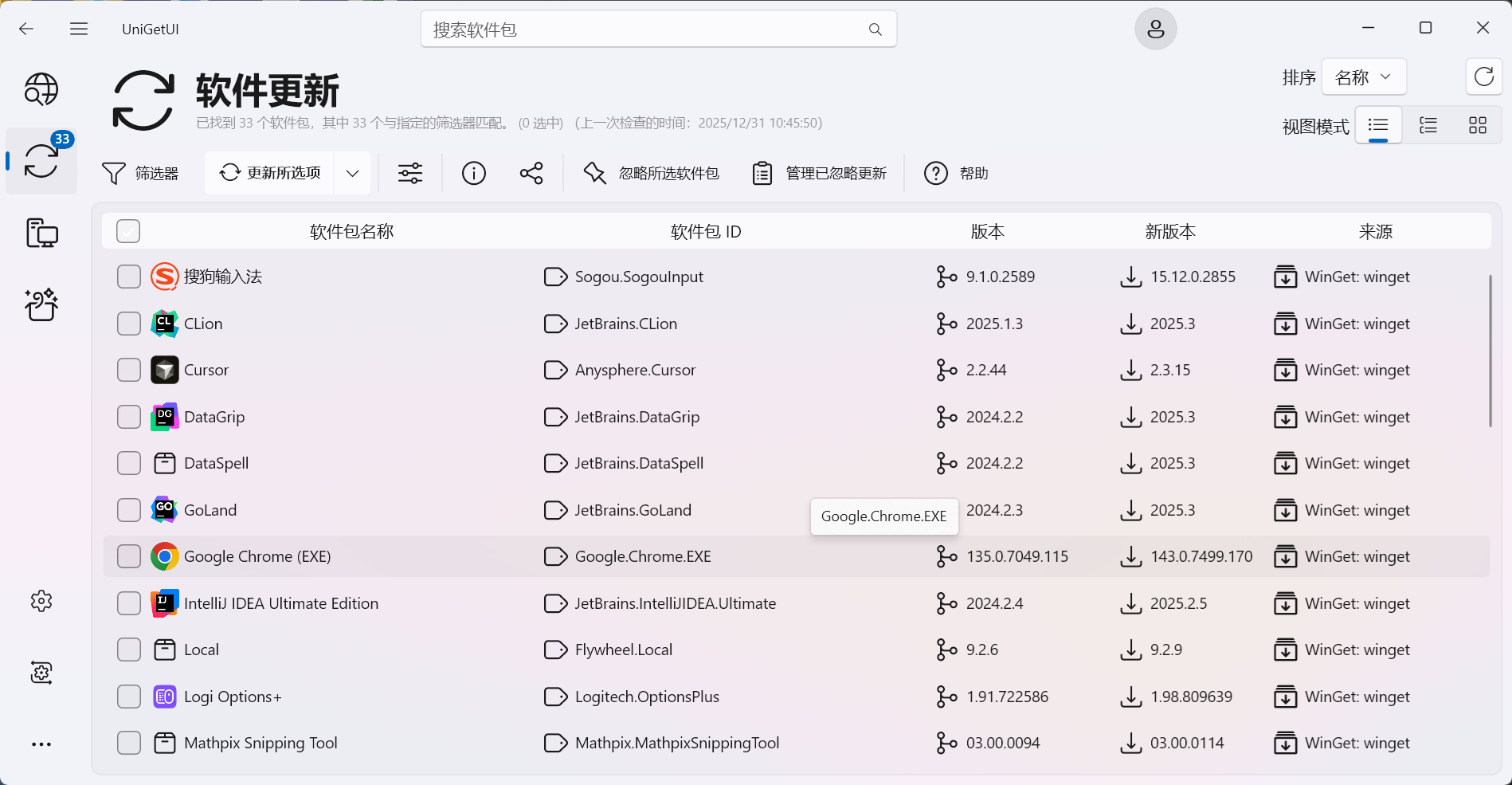

- 丰富的监控和调试工具:提供了一个直观的WebUI,用户可以查看管道的执行状态、任务日志和性能指标。支持详细的错误报告和重试机制。

- 扩展性和集成性:Dagster提供了多种内置集成,支持与外部系统和服务(如AWS、GCP、Kubernetes等)的无缝集成。用户可以通过编写自定义实体和资源来扩展功能。

- 数据依赖管理:Dagster支持通过实体间的数据依赖关系自动管理任务的执行顺序,确保数据处理的正确性和一致性。

- 社区支持和文档:拥有活跃的开源社区和丰富的文档资源,帮助用户快速上手和解决问题。

适用场景

- 数据工程:适合处理复杂的数据管道,涉及多个步骤的数据清洗、转换和加载(ETL)任务。

- 机器学习工作流:可用于管理和调度机器学习模型的训练、评估和部署工作流。

- 数据分析和报告生成:自动化生成定期报告和数据分析任务,确保数据的及时性和准确性。

Dagster的使用

使用Dagster来管理和编排数据工作流涉及几个关键步骤,从安装到定义实体和管道,再到运行和监控工作流。以下是使用Dagster的基本指南:

安装Dagster

首先,确保Python环境可用,然后使用pip安装Dagster和其WebUI工具Dagit:pip install dagster dagit定义实体(Solids)和管道(Pipelines)

在Dagster中,实体(Solids)是数据处理的基本单元,而管道(Pipelines)是由多个实体组成的工作流。以下是一个简单的示例:

from dagster import solid, pipeline, execute_pipeline

@solid

def get_name(context):

return "Dagster"

@solid

def hello(context, name: str):

context.log.info(f"Hello, {name}!")

@pipeline

def hello_pipeline():

hello(get_name())

# 执行管道

if __name__ == "__main__":

execute_pipeline(hello_pipeline)

运行和测试管道

在开发过程中,可以使用execute_pipeline函数在本地测试管道,如上面的示例所示。

使用Dagit进行可视化监控

Dagit是Dagster提供的WebUI工具,用于可视化和监控管道的执行。要启动Dagit,请运行以下命令,并指定包含管道定义的Python文件:dagit -f your_script.py

然后在浏览器中访问http://localhost:3000,你可以看到管道的执行状态、任务日志和其他相关信息。

配置资源和模式

Dagster支持通过模式(Mode)和资源(Resource)配置管道的执行环境:

from dagster import resource, ModeDefinition

@resource

def db_resource(init_context):

# 初始化数据库连接或其他资源

return "database_connection"

@solid(required_resource_keys={"db"})

def fetch_data(context):

db_conn = context.resources.db

# 使用数据库连接执行操作

return "fetched_data"

@pipeline(mode_defs=[ModeDefinition(resource_defs={"db": db_resource})])

def my_pipeline():

fetch_data()

使用调度器进行自动化

Dagster支持定期调度管道运行,可以通过编写调度器配置文件实现:

from dagster import schedule

@schedule(cron_schedule="0 0 * * *", pipeline_name="my_pipeline")

def daily_schedule(_context):

return {}

扩展和集成

Dagster提供了丰富的扩展和集成选项,可以与外部系统和服务(如AWS、GCP、Kubernetes等)无缝集成。用户可以编写自定义实体、资源和类型来扩展功能。

部署

Dagster可以在本地开发环境中运行,也可以部署在云环境或容器化平台上,如Kubernetes。Dagster的灵活性使其适用于各种规模的项目和基础设施。

与Prefect和Luigi的对比

Dagster、Prefect和Luigi是三种流行的工作流编排工具,各自有其独特的设计理念和功能特性。以下是对这三者的详细对比:

| 特性/方面 | Dagster | Prefect | Luigi |

| 开发背景 | Dagster是一个现代化的数据工作流编排工具,专注于数据管道的开发和测试 | Prefect是一个现代的工作流编排工具,强调提高数据管道的可靠性和可扩展性 | Luigi由Spotify开发,专注于批处理数据管道 |

| 核心概念 | 基于Solids和Pipelines,支持强类型和资源管理 | 基于Flow和Task,支持动态任务生成和复杂的依赖管理 | 基于任务树和目标(Target),直接管理任务和依赖关系 | 提供直观的 WebUI(Dagit)用于监控和调试管道 | 提供功能丰富的 WebUI,用于监控和管理 Flow | 提供简单的 Web 界面,功能基础 |

| 调度能力 | 支持定期调度和事件驱动调度,灵活的模式和资源配置 | 支持灵活的调度策略,包括周期性调度和事件驱动调度 | 基本的调度功能,适合中小规模的工作流 |

| 扩展性 | 支持用户定义的类型和资源,易于与外部系统集成 | 广泛的集成支持,易于与云平台和容器化环境集成 | 支持与 Hadoop、Spark、SQL 数据库、AWS S3 等集成 |

| 动态任务生成 | 支持通过实体间的依赖关系管理任务执行顺序 | 支持动态任务生成,根据运行时条件动态创建任务 | 不支持动态任务生成,任务在定义时就固定 |

| 错误处理 | 提供详细的错误报告和调试工具 | 提供详细的错误报告和重试机制 | 自动化的错误处理和重试机制 |

| 云原生支持 | 支持 Kubernetes 等云原生环境,适合容器化部署 | 高度兼容云原生架构,支持 Kubernetes、Docker 等环境 | 主要用于本地和简单的集群环境 |

| 社区和支持 | 拥有活跃的开源社区和丰富的文档资源 | 拥有活跃的社区和现代的开发支持 | 社区规模较小,活跃度相对较低 |

| 适用场景 | 复杂的数据管道和工作流,特别适合数据工程和数据科学项目 | 复杂的数据管道和工作流,适用于数据工程和数据科学 | 简单的批处理数据管道,直接依赖管理 |

| 任务定义 | 使用 Python 装饰器定义实体和管道,支持强类型和资源配置 | 使用 Python 装饰器和上下文管理,任务和 Flow 的定义更直观 | 使用 Python 类和函数定义,任务以任务树形式组织 |

总结

- Dagster:Dagster 提供了一个现代化的编程模型,特别适合数据工程和数据科学项目。它强调类型安全、资源管理和可测试性,适用于复杂的数据管道。其直观的 WebUI(Dagit)为用户提供了强大的监控和调试工具。

- Prefect:Prefect 强调灵活性和可扩展性,适用于需要动态任务生成和复杂依赖管理的场景。其强大的 WebUI 和错误处理机制使得管理和监控工作流变得更为简单。Prefect 的云原生支持使其适合现代数据基础设施。

- Luigi:Luigi 是一个成熟的工具,适合用于构建简单的批处理数据管道。它的设计更关注于任务的直接依赖管理,适合中小规模的工作流。对于需要快速搭建简单数据管道的场景,Luigi 是一个不错的选择。

选择合适的工具通常取决于具体的需求和项目环境。如果项目涉及复杂的数据工作流和云原生环境,Dagster 或 Prefect 可能是更好的选择。而对于简单的批处理任务,Luigi 则可能更为合适。

参考链接: