Apache Arrow 是一个跨语言的开发平台,用于处理和分析大数据。它的主要目标是提高数据分析的速度和效率,尤其是在需要在不同系统或编程语言之间共享数据时。

Apache Arrow 简介

产生背景

Apache Arrow 的产生背景与现代大数据处理和分析需求的演变密切相关。在大数据领域,随着数据规模的不断增长和多样化,传统的数据处理方式逐渐显现出了一些瓶颈,尤其是在不同系统之间传递数据时。以下是 Apache Arrow 产生的一些关键背景:

- 大数据生态系统的多样性:随着大数据技术的发展,出现了许多不同的工具和框架,如Apache Hadoop、Apache Spark、Apache Kafka 等。这些工具各自有不同的优势,但在数据共享和传递上常常需要复杂的序列化和反序列化过程,导致性能瓶颈。

- 序列化和反序列化的开销:在分布式系统中,不同组件之间的数据传输通常需要序列化为一种中间格式,然后在接收端反序列化。这一过程不仅耗时,而且消耗大量的计算资源,尤其是在需要频繁数据交换的场景下。

- 内存和计算效率的需求:数据科学和分析任务通常需要对大规模数据集进行快速扫描和计算。这需要高效的内存布局和访问模式,以便充分利用现代 CPU 的缓存和指令集。

- 跨语言数据处理的挑战:数据处理任务常常需要跨多种编程语言进行。例如,数据可能在 Java 中被生成,然后在 Python 中进行分析,最后在 R 中可视化。不同语言间的数据传递需要高效且无缝的解决方案。

- 列式存储的优势:列式存储格式在数据仓库和分析中表现出色,因为它们可以更有效地压缩数据并提高扫描速度。这种存储方式在内存中的应用可以带来显著的性能提升。

基于以上背景,Apache Arrow 项目于 2016 年由开源社区发起,旨在提供一个统一的、跨语言的内存数据格式,以解决数据在不同系统和语言之间高效传输和处理的问题。Arrow 的设计目标是最大化内存和计算效率,通过零拷贝的数据共享和高效的列式内存布局,为现代大数据处理任务提供强有力的支持。它的出现标志着大数据处理技术向着更高效和更具互操作性的方向发展。

核心特性

Apache Arrow 是一个为高效数据分析和处理设计的跨语言开发平台,其特性使其成为大数据处理领域的重要工具。以下是 Apache Arrow 的一些关键特性:

- 列式内存格式:Arrow 使用列式内存布局,这种布局在数据分析中非常高效,特别是在需要对大量数据进行扫描和聚合的操作时。列式存储允许更好的数据压缩和更快的查询性能,因为它减少了对不相关数据的读取。

- 跨语言支持:Arrow 提供对多种编程语言的支持,包括 C++, Java, Python, R, Go, JavaScript 等。这种多语言支持使得开发者可以在不同的语言环境中共享数据而不需要昂贵的序列化和反序列化过程。

- 零拷贝共享:Arrow 允许在不同计算引擎或进程之间实现零拷贝的数据共享。这意味着数据可以在系统之间快速传递,减少了数据复制带来的开销。

- 高效的数据访问和计算:Arrow 的设计利用现代 CPU 的特性(如缓存和指令集),提供高效的数据访问模式和计算能力。这使得在 Arrow 上进行的分析任务能够充分利用硬件资源。

- 与大数据工具集成:Arrow 与许多大数据工具和框架集成良好,例如 Apache Spark、Pandas、Dask 和 Apache Drill。这种集成能力使得 Arrow 可以无缝融入现有的数据处理生态系统。

- 表达式求值引擎(Gandiva):Arrow 包含一个基于 LLVM 的表达式求值引擎,称为 Gandiva。它能够在 Arrow 数据上执行高效的计算和表达式求值,进一步提高性能。

- 标准化数据格式:Arrow 提供了一种标准化的方式来描述数据的结构和类型,这对于跨系统的数据交换和处理非常重要。

- 社区支持和持续发展:Arrow 是 Apache 软件基金会的顶级项目之一,拥有一个活跃的开源社区,持续为其添加新功能和改进性能。

这些特性使得 Apache Arrow 成为处理和分析大规模数据集的理想选择,特别是在需要跨不同语言和系统进行数据共享和计算的场景中。通过提供高效的内存格式和丰富的功能,Arrow 显著提高了数据处理的效率和速度。

缺点与不足

- 学习曲线:对于新用户来说,理解和有效利用 Arrow 的内存格式和特性可能需要一些时间,特别是如果他们习惯于行式存储的处理方式。

- 内存消耗:虽然 Arrow 提供了高效的内存使用,但在处理极大数据集时,内存消耗仍可能成为一个问题,尤其是在内存有限的环境中。

- 生态系统的成熟度:尽管 Arrow 在快速发展,但与一些更成熟的工具相比,其生态系统可能在某些特定领域还不够完善。

- 依赖硬件特性:Arrow 的性能优化依赖于现代 CPU 的特性,因此在较旧或较弱的硬件上可能无法充分发挥其优势。

- 缺乏某些高级功能:与一些专门的数据处理库相比,Arrow 可能缺乏某些高级的分析功能,需要与其他工具结合使用。

应用场景

Apache Arrow 是一个专为高效数据处理和分析设计的跨语言平台,其特性使其在多个应用场景中具有显著优势。以下是一些常见的应用场景:

- 大数据分析:在需要处理和分析大规模数据集的场景中,Arrow 的列式内存格式可以显著提高查询和聚合操作的性能。它适合用于需要快速扫描大量数据的任务,如实时数据分析和报表生成。

- 跨语言数据共享:Arrow 支持多种编程语言,使得在不同语言环境(如从 Java 到 Python,再到 R)之间高效共享数据成为可能。这对于多语言数据处理流水线或需要跨团队合作的项目尤为重要。

- 分布式计算:在分布式系统中,Arrow 的零拷贝数据共享特性可以减少数据在节点之间传输的开销,提高整体系统的性能。这对于需要频繁数据交换的分布式计算框架(如 Apache Spark)非常有用。

- 机器学习和数据科学:Arrow 可以用于加速数据预处理和特征工程步骤,这是机器学习和数据科学工作流中的关键环节。通过与 Pandas 和其他数据科学工具的集成,Arrow 可以帮助快速加载和处理大型数据集。

- 实时数据处理:在需要实时或近实时处理数据的场景中,Arrow 的高效内存格式和快速数据访问能力可以显著提高处理速度。这对于金融市场数据分析、物联网数据流处理等应用场景非常关键。

- 数据仓库和 OLAP:Arrow 可以用于数据仓库和在线分析处理(OLAP)系统中,通过其列式存储格式提供快速的查询性能和压缩效率。

- 流式数据处理:在需要处理流式数据的应用中,Arrow 的高效内存布局和快速数据访问能力可以支持高吞吐量和低延迟的数据处理。

- ETL(Extract, Transform, Load)流程:Arrow 可以在 ETL 流程中使用,通过提供高效的数据传输和转换能力,加速数据的提取、转换和加载过程。

- 数据湖和云存储:在数据湖和云存储解决方案中,Arrow 可以用于高效地存储和检索数据,尤其是在需要与其他大数据工具集成的情况下。

总之,Apache Arrow在需要高效数据处理、跨语言数据共享以及与大数据生态系统紧密集成的场景中表现出色。它为开发者和数据科学家提供了一个强大而灵活的工具来应对现代数据处理挑战。

生态系统

Apache Arrow的生态系统是一个多元化且不断发展的集合,涵盖了多个项目和工具,这些工具利用Arrow的高效内存格式来提高数据处理和分析的性能。以下是Apache Arrow生态系统中的一些关键组件和集成:

- 数据框架和工具集成:

- Pandas:在Python中,Arrow可以与Pandas集成,提供更快的数据帧操作,尤其是在数据序列化和反序列化方面。

- Dask:支持使用Arrow格式进行高效的并行计算和大数据集的处理。

- R:Arrow为R提供了数据框架的支持,使得R用户可以利用Arrow的性能优势。

- 大数据处理引擎:

- Apache Spark:Arrow被用于Spark中的Python和R数据帧操作中,以提高性能和减少数据传输的开销。

- Apache Drill:利用Arrow进行高效的查询处理和数据分析。

- Apache Flink:在流式处理场景中,Arrow可以用来优化数据传输和计算。

- 存储格式和文件系统:

- Apache Parquet:Arrow与Parquet密切集成,Parquet用于磁盘上的列式存储,而Arrow用于内存中的列式格式,这种组合可以提供从磁盘到内存的高效数据加载。

- ORC:类似于Parquet,ORC也可以与Arrow集成,用于高效的数据存储和检索。

- 云和数据湖解决方案:Arrow的格式被许多云服务和数据湖解决方案采用,用于优化数据存储和访问,尤其是在大规模数据处理和分析的场景中。

- 数据库和查询引擎:一些现代数据库和查询引擎(如ClickHouse)也在使用Arrow来提高查询性能和数据传输效率。

- 计算库和表达式求值:

- Gandiva:这是Arrow的一个子项目,提供了一个基于LLVM的表达式求值引擎,用于在Arrow数据上执行高效的计算。

- 消息传递和流处理:Arrow的格式被一些消息传递和流处理框架采用,以实现高效的数据传输和处理。

- 可视化工具:一些数据可视化工具也开始支持Arrow,以便快速加载和渲染大规模数据集。

Apache Arrow的生态系统通过与多种工具和框架的集成,提供了一个高效且灵活的数据处理平台。随着越来越多的项目采用Arrow作为其核心数据格式,Arrow的生态系统将继续扩展,为开发者和数据科学家提供更多的选择和可能性。

未来发展

Apache Arrow作为一个不断发展的开源项目,其未来发展方向充满潜力。以下是一些可能的未来发展趋势和重点:

- 扩展语言支持:目前,Arrow已支持多种语言(如C++, Java, Python, R等),未来可能会进一步扩展对其他编程语言的支持,以吸引更多的开发者和用户。

- 性能优化:继续优化Arrow的内存格式和计算引擎,以利用最新的硬件特性(如GPU加速、向量化指令集等),提升数据处理和分析的性能。

- 功能扩展:增强现有功能,如更复杂的数据类型支持、改进的序列化和反序列化性能,以及更强大的表达式求值能力。

- 更广泛的集成:扩大与其他大数据和云平台的集成,如支持更多的数据库、数据仓库、流处理框架和数据湖解决方案。

- 社区发展:通过吸引更多的开发者和企业用户来扩大社区,推动项目的持续发展和创新。

- 标准化和互操作性:Arrow可能会在数据格式标准化和互操作性方面发挥更大的作用,促进跨系统的数据交换和集成。

- 数据安全和治理:增强数据安全性和治理功能,以满足企业级用户在数据隐私和合规性方面的需求。

- 支持云原生架构:随着云计算的普及,Arrow可能会增加对云原生架构的支持,使其在云环境中更易于部署和使用。

- 教育和培训:开发更多的教育资源和培训材料,以帮助用户更好地理解和使用Arrow。

- 新的应用场景:探索新的应用场景,如物联网数据处理、边缘计算和实时分析,扩大Arrow的应用范围。

通过这些发展方向,Apache Arrow有望在未来成为数据处理和分析领域的一个核心组件,为各种规模和类型的应用提供高效、灵活的数据处理解决方案。随着技术的不断进步和数据需求的增加,Arrow的角色和影响力将继续增长。

Apache Arrow的实现

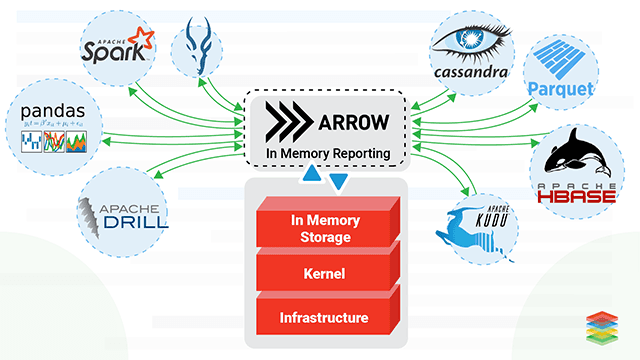

Arrow项目的愿景是提供内存数据分析 (in-memory analytics) 的开发平台,让数据在异构大数据系统间移动、处理地更快:

项目主要由3部分构成:

- 为分析查询引擎 (analytical query engines)、数据帧 (dataframes) 设计的内存列存数据格式

- 用于IPC/RPC的二进制协议

- 用于构建数据处理应用的开发平台

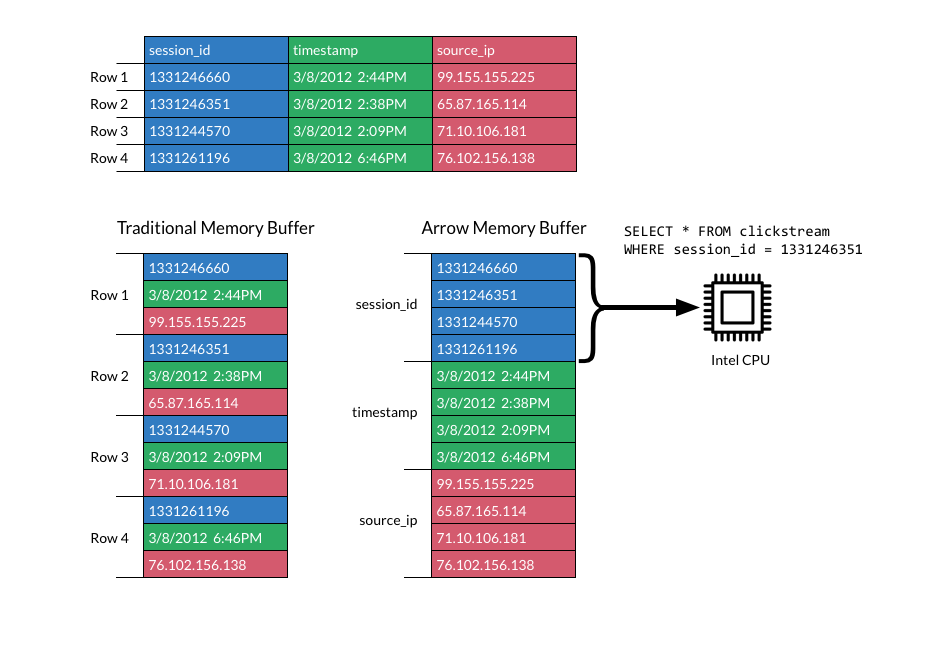

整个项目的基石是基于内存的列存数据格式,现在将它的特点罗列如下:

- 标准化 (standardized),与语言无关 (language-independent)

- 同时支持平铺 (flat) 和层级 (hierarchical) 数据结构

- 硬件感知 (hardware-aware)

Arrow的内存数据结构如下所示:

从上图中,我们可以很清晰的看出,传统的内存数据格式,各个字段的分布是以没一行呈现,相同字段并未集中排列在一起。而通过Arrow格式化后的内存数据,可以将相同字段集中排列在一起。我们可以很方便的使用SQL来操作数据。

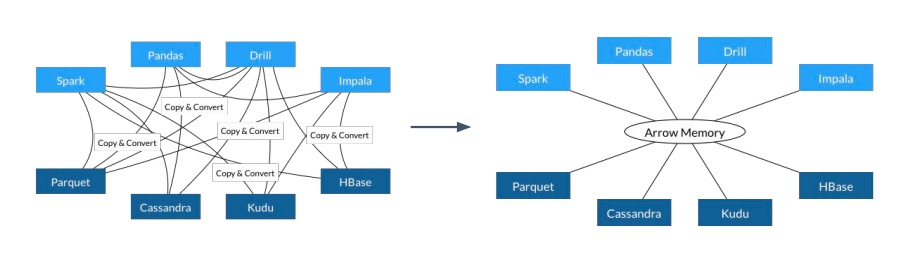

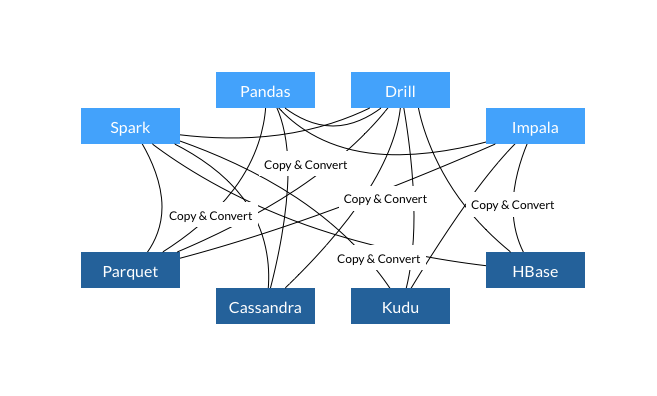

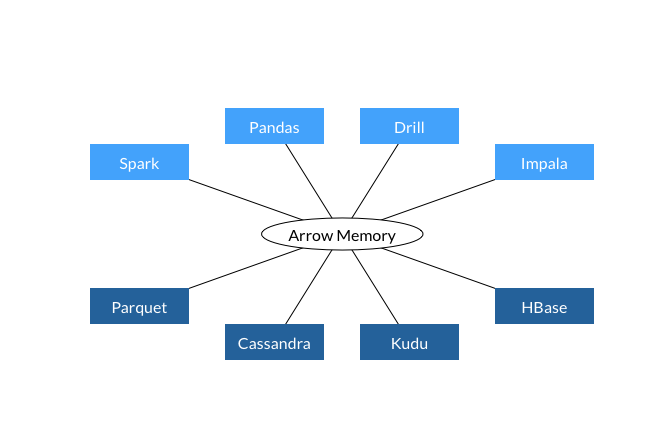

传统的访问各个数据模型中的数据以及使用Arrow后的图,如下所示:

通过上图可以总结出以下观点:

- 每个系统都有属于自己的内存格式。

- 70~80%的CPU浪费在序列化和反序列化上。

- 在多个项目都实现的类似的功能(Copy & Convert)。

而在看上述使用Arrow后,得出以下结论:

- 所有的系统都使用相同的内存格式。

- 没有跨系统通信开销。

- 项目可以贡献功能(比如,Parquet到Arrow的读取)。

Apache Arrow的使用

在Python中使用Apache Arrow可以通过pyarrow库实现。pyarrow提供了对Arrow内存格式的支持,以及与其他数据处理工具(如Pandas)的集成。以下是一些常见的用法示例,帮助你在Python中有效地使用Apache Arrow。

安装PyArrow

首先,你需要安装pyarrow库,可以通过pip安装:pip install pyarrow

基本用法

创建Arrow表

你可以使用pyarrow创建Arrow表和数组:

import pyarrow as pa # 创建一个Arrow数组 int_array = pa.array([1, 2, 3, 4]) # 创建一个Arrow表 table = pa.Table.from_arrays([int_array], names=['integers']) print(table)

与Pandas集成

Arrow可以与Pandas无缝集成,用于高效的数据转换:

import pandas as pd

import pyarrow as pa

import pyarrow.parquet as pq

# 创建一个Pandas DataFrame

df = pd.DataFrame({

'integers': [1, 2, 3, 4],

'floats': [0.1, 0.2, 0.3, 0.4],

'strings': ['a', 'b', 'c', 'd']

})

# 将Pandas DataFrame转换为Arrow表

table = pa.Table.from_pandas(df)

# 将Arrow表转换回Pandas DataFrame

df_from_arrow = table.to_pandas()

print(df_from_arrow)

读取和写入Parquet文件

Arrow支持高效的Parquet文件读写:

import pyarrow.parquet as pq

# 将Arrow表写入Parquet文件

pq.write_table(table, 'example.parquet')

# 从Parquet文件读取为Arrow表

table_from_parquet = pq.read_table('example.parquet')

print(table_from_parquet)

使用Arrow进行数据序列化

Arrow提供了高效的数据序列化和反序列化方法:

# 序列化Arrow表

sink = pa.BufferOutputStream()

with pa.RecordBatchFileWriter(sink, table.schema) as writer:

writer.write_table(table)

# 反序列化Arrow表

buffer = sink.getvalue()

reader = pa.RecordBatchFileReader(pa.BufferReader(buffer))

deserialized_table = reader.read_all()

print(deserialized_table)

其他功能

- 处理大数据:利用Arrow的列式存储和高效内存格式,处理大型数据集。

- 与其他数据工具集成:通过Arrow,与其他大数据处理框架(如Apache Spark)集成。

- 流式数据处理:支持对流式数据的高效处理和转换。

参考链接: