文章内容如有错误或排版问题,请提交反馈,非常感谢!

Ray简介

Ray是一个开源的分布式计算框架,专为机器学习和人工智能应用设计。它提供了一种灵活、高效的方式来构建和运行分布式应用程序,特别是在需要大规模并行计算的场景中。Ray的核心是一个通用的分布式执行引擎,支持无状态和有状态的计算任务。

核心特性

- 简化的分布式计算:

- Ray使得编写分布式应用程序变得简单,通过Python API提供对分布式计算资源的透明访问。

- 支持函数和类的分布式执行,用户可以轻松地将现有的单机代码扩展到分布式环境。

- 自动化的资源管理:

- Ray提供自动化的资源调度和负载均衡,优化计算资源的利用。

- 支持多种资源类型(如CPU、GPU)的管理和调度,适应不同的计算需求。

- 弹性和容错:

- Ray的架构支持任务的自动重试和故障恢复,确保应用的高可用性。

- 支持动态扩展和收缩计算资源,适应变化的工作负载。

- 高性能:

- 通过共享内存和零拷贝技术,Ray提供高效的数据传输和计算性能。

- 支持大规模并行计算和低延迟的任务调度。

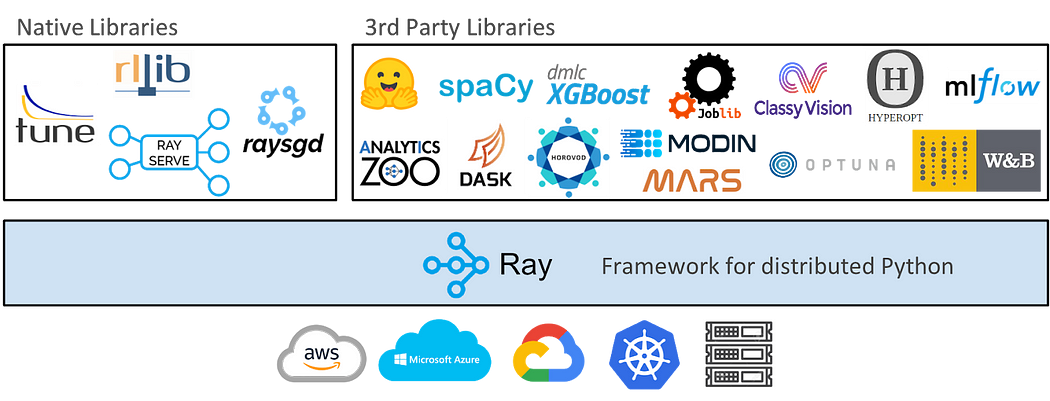

- 生态系统和集成:

- Ray提供丰富的库和工具支持,如Ray Tune(超参数调优)、Ray Serve(模型服务化)和Ray RLlib(强化学习)。

- 与主流的机器学习框架(如TensorFlow、PyTorch)无缝集成,支持复杂的机器学习工作流。

应用场景

- 机器学习和深度学习:

- 支持分布式训练、超参数调优和模型服务化,适合大规模机器学习应用。

- 与TensorFlow、PyTorch等框架集成,支持复杂的模型训练和部署。

- 强化学习:

- Ray RLlib提供了一个可扩展的强化学习库,支持多种算法和环境。

- 适用于需要大规模并行仿真和训练的强化学习任务。

- 数据处理和分析:

- 支持分布式数据处理和分析任务,适用于大规模数据集的处理。

- 提供与Pandas、NumPy等数据处理库的集成,简化数据分析工作流。

- 高性能计算(HPC):

- 适用于需要大规模并行计算和高性能的数据密集型应用。

- 支持科学计算、仿真和建模等HPC场景。

Ray的架构

Ray是一个开源的分布式计算框架,旨在提供简单易用的接口来开发和运行大规模的分布式应用程序。它特别适用于机器学习、强化学习和数据处理等需要大规模计算的场景。Ray的架构设计注重灵活性、可扩展性和高性能。

以下是Ray的主要架构组件及其功能:

核心组件

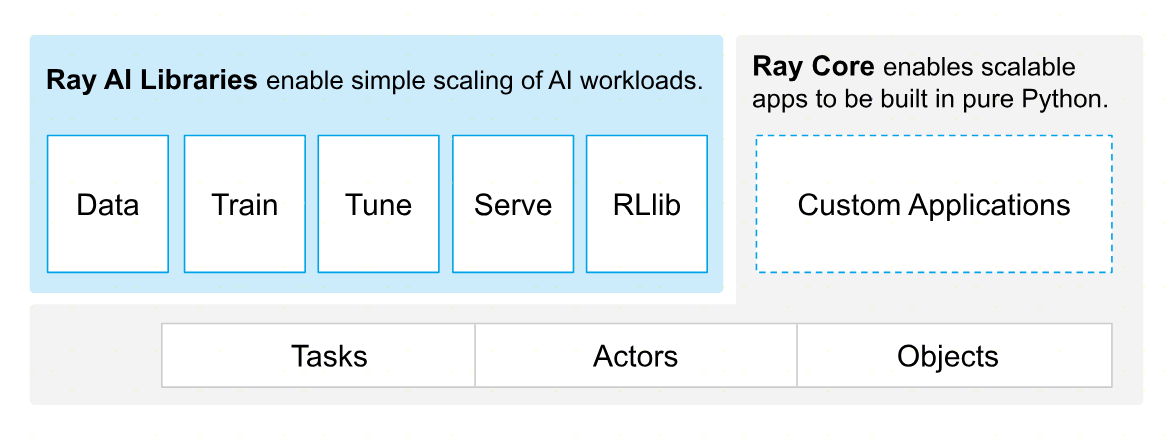

- Ray Core

- 任务和Actor模型:Ray提供了一个基于任务和Actor的并行计算模型。任务是无状态的函数调用,而Actor是有状态的计算单元。

- 调度器:负责在集群中调度和分配任务,确保任务的高效执行和资源的有效利用。

- 资源管理:跟踪和管理集群中的计算资源,支持动态扩展和负载均衡。

- Ray Cluster

- 节点类型:

- Head Node:集群的主节点,负责管理集群的状态、调度任务和协调节点之间的通信。

- Worker Nodes:执行具体任务的工作节点,负责处理分配给它们的任务和Actor。

- Ray Dashboard

- 提供一个Web界面,用于监控和管理Ray集群。用户可以查看集群的状态、资源使用情况、任务执行情况等。

- 节点类型:

数据管理

- 对象存储(Object Store):Ray使用共享内存对象存储来管理任务之间的数据传递。对象存储支持零拷贝数据共享,减少数据传输的开销。

- 对象引用:Ray使用对象引用来跟踪和管理数据对象,确保任务可以高效地访问和共享数据。

扩展和集成

- Ray Libraries:Ray提供了一系列库,支持不同的应用场景:

- Ray Tune:用于大规模超参数优化。

- Ray RLlib:用于分布式强化学习。

- Ray Serve:用于大规模模型服务和在线推理。

- 与其他工具的集成:Ray可以与常见的机器学习框架(如TensorFlow、PyTorch)和数据处理工具(如Apache Spark)集成,扩展其功能。

可扩展性和弹性

- 水平扩展:Ray支持动态添加和移除工作节点,以应对变化的计算需求。

- 故障恢复:Ray具有内置的故障恢复机制,可以自动重新调度失败的任务,确保计算的可靠性和连续性。

参考链接:

- Productionizing and scaling Python ML workloads simply | Ray

- ray-project/ray: Ray is an AI compute engine. Ray consists of a core distributed runtime and a set of AI Libraries for accelerating ML workloads. (github.com)

- Getting Started with Distributed Machine Learning with PyTorch and Ray | by PyTorch | PyTorch | Medium