文章内容如有错误或排版问题,请提交反馈,非常感谢!

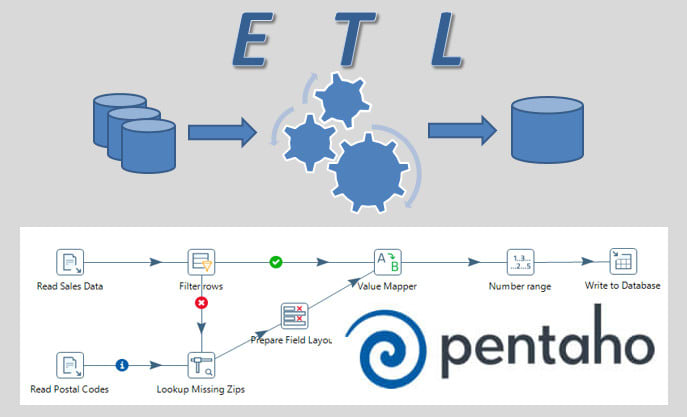

Kettle简介

Kettle(Pentaho Data Integration)是一个功能强大且灵活的开源数据集成工具,专为需要高效处理和转换数据的用户设计。通过提供丰富的转换功能和广泛的数据源支持,Kettle帮助用户实现复杂的数据集成任务。其易用的图形化界面和强大的扩展能力使其成为数据仓库建设、数据迁移和大数据处理等多个领域的理想选择。

核心特性

- 图形化设计界面:

- 提供用户友好的图形化界面,用户可以通过拖放组件来设计ETL流程。

- 直观的工作流设计,减少了编写代码的复杂性,适合技术背景不同的用户。

- 多种数据源支持:

- 支持多种数据源的连接,包括关系型数据库(如MySQL、PostgreSQL、Oracle)、NoSQL数据库(如MongoDB)、文件(如CSV、Excel)、云服务等。

- 提供灵活的数据连接和转换选项,支持从异构数据源中提取数据。

- 丰富的数据转换功能:

- 提供多种内置的转换步骤,包括数据过滤、排序、聚合、合并、拆分等。

- 支持自定义脚本和插件扩展,满足复杂的数据转换需求。

- 可扩展性和灵活性:

- 支持通过Java和JavaScript编写自定义步骤和插件,增强功能的灵活性。

- 提供强大的API,允许与其他应用和服务集成。

- 大数据支持:

- 支持与Hadoop和Spark等大数据平台的集成,适用于大数据环境中的ETL任务。

- 提供与HDFS、Hive、HBase等大数据存储的连接器。

- 调度与自动化:

- 支持任务调度和自动化运行,用户可以设定定时执行的工作流。

- 提供日志记录和错误处理机制,帮助监控和管理ETL流程。

应用场景

- 数据仓库建设:

- 用于从多个源系统中提取数据,并在数据仓库中进行清洗、转换和加载。

- 支持构建企业级数据仓库,提供一致性和高质量的数据。

- 数据迁移与整合:

- 支持在不同系统之间迁移和整合数据,帮助实现系统集成和数据一致性。

- 适用于企业系统升级、数据合并和迁移项目。

- 商业智能与分析:

- 为商业智能平台提供清洗和转换后的数据支持,帮助进行数据分析和决策支持。

- 提供高效的数据准备和预处理功能。

- 大数据处理:

- 适用于大数据环境中的ETL任务,支持处理海量数据和复杂的数据操作。

- 提供与大数据技术的无缝集成,支持实时和批处理模式。

Kettle的挑战

开源的Kettle(也称为Pentaho Data Integration)在数据集成和ETL(提取、转换、加载)工具中有一定的知名度,但与其他一些更流行的工具相比,它的使用率可能不算特别高,原因包括以下几个方面:

- 市场竞争激烈:ETL和数据集成市场竞争非常激烈,有很多强大的工具和平台,如Apache Nifi、Apache Airflow、Informatica等,这些工具各自有其独特的优势和特性。

- 用户界面和易用性:虽然Kettle提供了图形化的用户界面,但有些用户可能觉得它不如其他一些现代工具直观和用户友好。

- 社区和支持:虽然Kettle是开源的,但其社区活动可能不如一些其他开源项目活跃。这可能导致用户在遇到问题时获取支持和资源的难度增加。

- 功能和性能:对于某些复杂的ETL任务或大规模数据处理,Kettle可能在功能和性能上不如一些专有或更成熟的工具。

- 技术趋势:随着数据处理技术的快速发展,许多公司开始转向云原生解决方案和流处理架构,这些趋势可能减少了对传统ETL工具的需求。

- 企业版和商业支持:虽然有开源版本,但Pentaho也提供商业版本,许多企业可能更倾向于使用商业版本以获得更好的支持和更多功能。

这些因素可能导致Kettle在某些场景下不如其他工具流行。然而,它仍然是一个功能强大且灵活的ETL工具,适合许多中小型项目和对开源有偏好的团队。

参考链接: