文章内容如有错误或排版问题,请提交反馈,非常感谢!

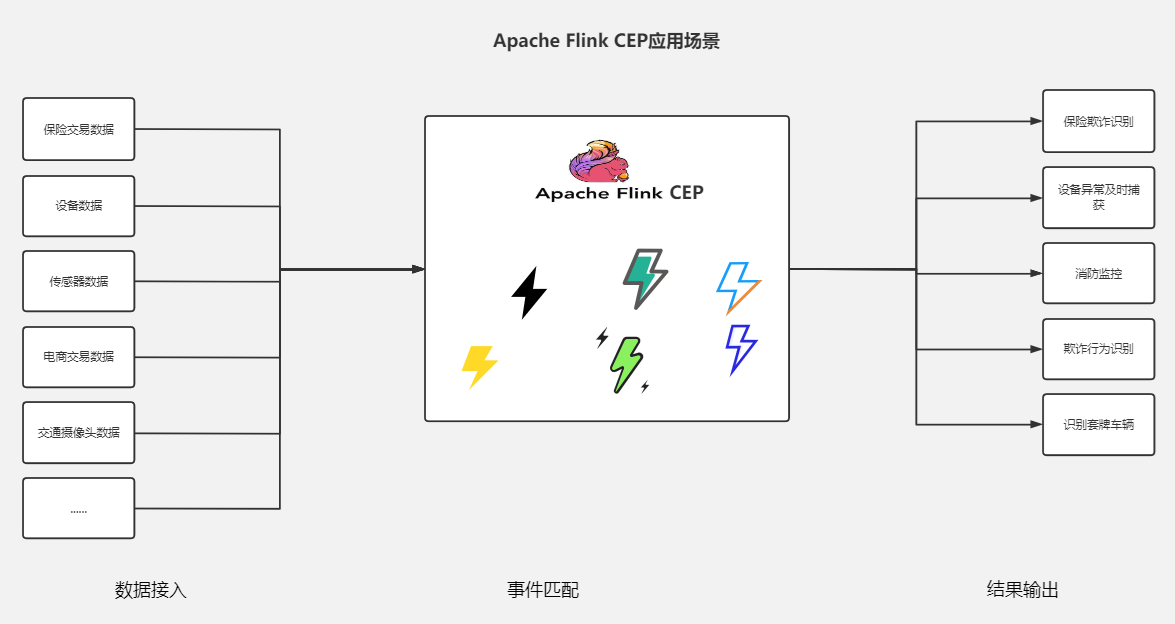

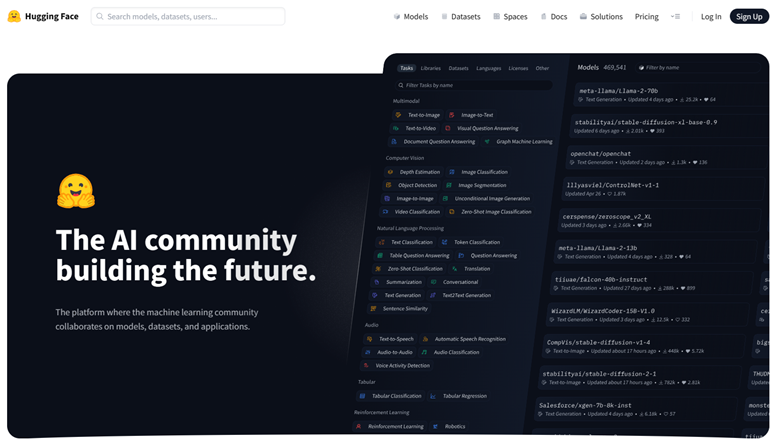

HuggingFace是一个领先的自然语言处理(NLP)和机器学习(ML)社区和平台,它为研究人员、开发者和企业提供了多种工具和资源。以下是HuggingFace的一些主要特点:

- 模型库:HuggingFace提供了一个庞大的预训练模型库,包括BERT、GPT、T5、ERNIE等各种模型,适用于不同的语言和任务。这些模型可以用于文本分类、文本生成、情感分析、问答系统等多种NLP任务。

- Transformers库:HuggingFace的Transformers库是一个非常流行的开源库,它提供了一种简单的方法来下载和使用这些预训练模型。Transformers库支持多种深度学习框架,如PyTorch、TensorFlow和JAX。

- 社区和协作:HuggingFace拥有一个活跃的社区,研究人员和开发者可以在此分享模型、数据集和最佳实践。此外,HuggingFace还提供了协作工具,如ModelHub和DatasetsHub,让用户可以轻松地共享和查找模型和数据集。

- 简化NLP任务:HuggingFace的目标之一是使NLP更加易于访问和使用。它的工具和库被设计得非常直观,即使是对机器学习不太熟悉的开发者也能轻松地开始NLP项目。

- 研究和创新:HuggingFace不仅提供现有模型的访问,还积极参与最新NLP研究的推进。它经常发布最新的研究成果和技术更新,推动整个领域的发展。

当你在国内使用HuggingFace模型是,会报如下的错误:

SSLError: HTTPSConnectionPool(host='huggingface.co', port=443): Max retries exceeded with url: /dslim/bert-base-NER/resolve/main/tokenizer_config.json (Caused by SSLError(SSLCertVerificationError(1, '[SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: self signed certificate in certificate chain (_ssl.c:1108)')))

主要原因是huggingface.co这个域名在国内无法访问

解决方案一:使用镜像网站(推荐)

使用hf-mirror.com作为镜像。

- 安装依赖:pip install huggingface_hub

- 设置环境变量HF_ENDPOINT=https://hf-mirror.com

完成后重启Pycharm就能正常下载模型了

解决方案二:从镜像网站下载模型后指定本地文件夹

这里推荐的是异型岛,异型岛社区版是HuggingFace资源下载网站,为AI开发者提供模型下载服务,通过下载器可以提高下载速度,解决大模型下载时间长、经常断线、需要反复重试等问题,实现镜像加速、断点续传、无人值守下载。

使用方法:

pip install huggingface_hub python model_download.py --repo_id 模型ID #例如 python model_download.py --repo_id Qwen/Qwen-7B

下载完后将AutoModel.from_pretrained的pretrained_model_name_or_path参数指向到本地文件夹,示例:

#以THUDM/chatglm-6b模型为例 #model_path="THUDM/chatglm-6b" #从huggingface.co装载模型的方法 model_path="./model/" #从本地文件夹装载模型的方法 tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True) model = AutoModel.from_pretrained(model_path, trust_remote_code=True).half().cuda()

解决方案三:使用国内平台modelscope

ModelScope是阿里创建的一个ai社区,可以通过该平台进行模型下载。

ModelScope的安装:pip install modelscop

模型的使用:

from modelscope.models import Model

model = Model.from_pretrained('thomas/m3e-base')

from modelscope import AutoTokenizer, AutoModelForCausalLM, snapshot_download

model_dir = snapshot_download("qwen/Qwen-7B-Chat-Int4")